Im Jahr 2025 hat die künstliche Intelligenz (KI) die Phase der frühen Erprobung und der ersten Einführung hinter sich gelassen und tritt nun in eine Phase der breiten Anwendung und des groß angelegten industriellen Einsatzes ein. Ob es sich um das Training von Modellen in ultragroßem Maßstab oder um Schlussfolgerungen mit niedriger Latenz in Geschäftsanwendungen handelt, die Anwendungsszenarien und Datenmengen von KI wachsen explosionsartig. Diese Wachstumswelle verändert nicht nur die Struktur der Rechenressourcen, sondern auch das Anforderungsprofil der Speicherebene - insbesondere Solid-State-Laufwerke (SSDs). Als Schlüsselkomponente für das Lesen und die Speicherung von Daten sind SSDs nicht mehr nur passive "Kapazitäts"-Module, sondern werden zu entscheidenden Leistungs- und Intelligenzelementen auf Systemebene.

Der Hintergrund: Wie KI die Speichernachfrage antreibt

In den letzten Jahren sind die Größe von KI-Modellen und der für das Training benötigte Rechenaufwand in erstaunlichem Maße gestiegen. Nach Angaben von der KI-Index-Bericht 2025 Aus dem Stanford HAI geht hervor, dass sich die Trainingsberechnungen namhafter KI-Modelle in immer kürzeren Zeitspannen verdoppelt haben und auch die Größe der Datensätze rapide zunimmt, was bedeutet, dass das Training eines großen KI-Modells nun exponentiell mehr Speicher-, Bandbreiten- und Persistenzressourcen erfordert. Noch wichtiger ist, dass diese groß angelegten Modelle nicht mehr nur in Entwicklungsumgebungen, sondern auch in breiten Unternehmensumgebungen und in Online-Inferenzszenarien zum Einsatz kommen, was die Nachfrage nach Speichersystemen mit niedriger Latenz und hoher Gleichzeitigkeit erhöht.

Um es ins rechte Licht zu rücken: Cloud-Training erfordert Rohdaten im Petabyte-Bereich und Hunderte von Terabyte bis Petabyte an Modellgewichten, während Inferenz- und Retrieval-Augmented-Generating-Szenarien (RAG) Tausende von kleinen zufälligen E/A-Anforderungen und hohe gleichzeitige Lesevorgänge mit sich bringen. Diese Trends stellen eine Herausforderung für SSDs dar, der eine einfache Erhöhung der Kapazität nicht gerecht wird.

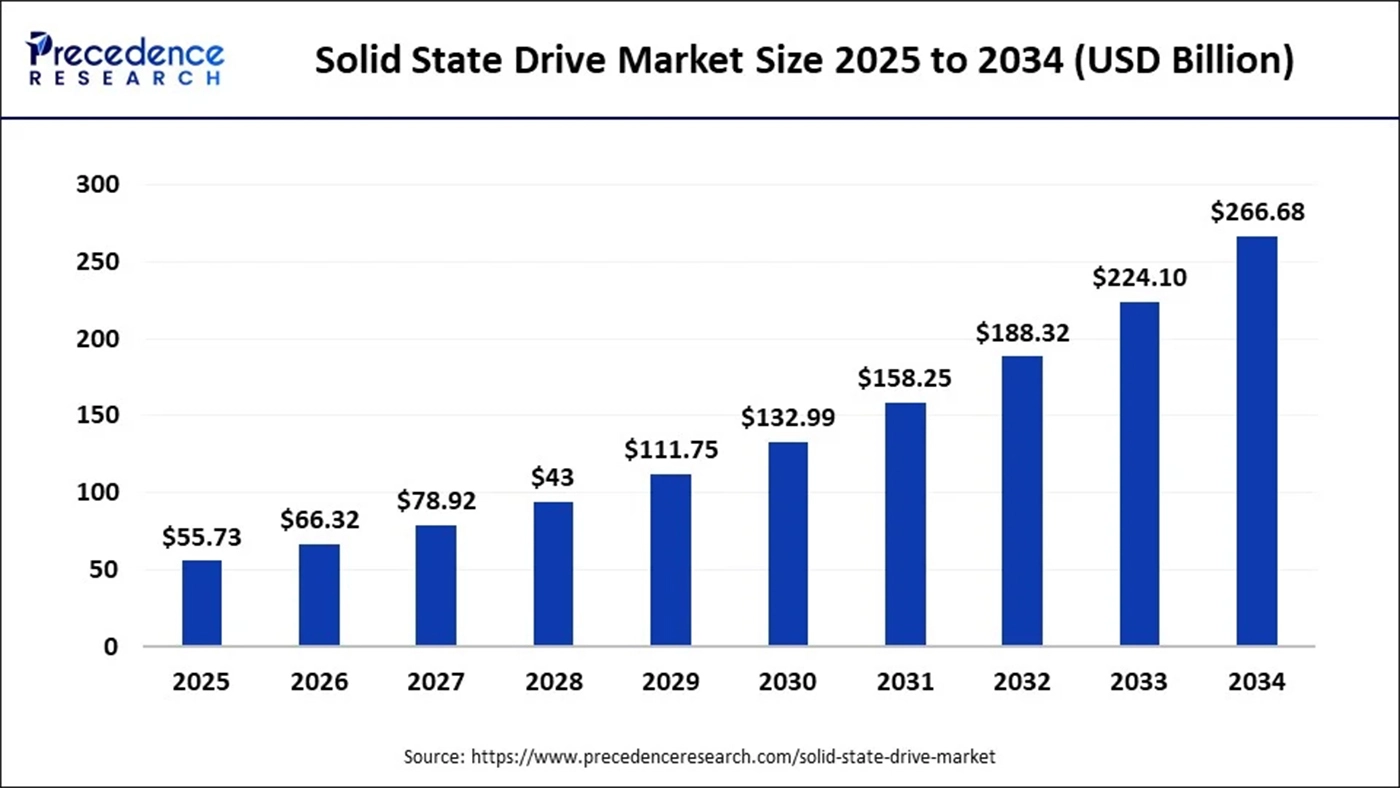

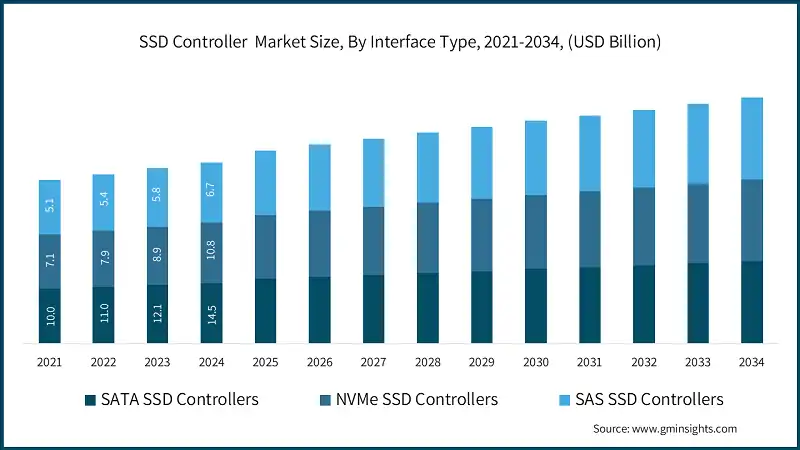

Die Prognosen der Marktforschungsunternehmen für den SSD-Markt spiegeln KI als einen der wichtigsten Wachstumstreiber wider. Eine Prognose zeigt zum Beispiel, dass die Größe des globalen SSD-Marktes im Jahr 2025 bei etwa 55,73 Milliarden USDmit einem Anstieg der Prognosen auf etwa 266,68 Milliarden USD bis 2034.

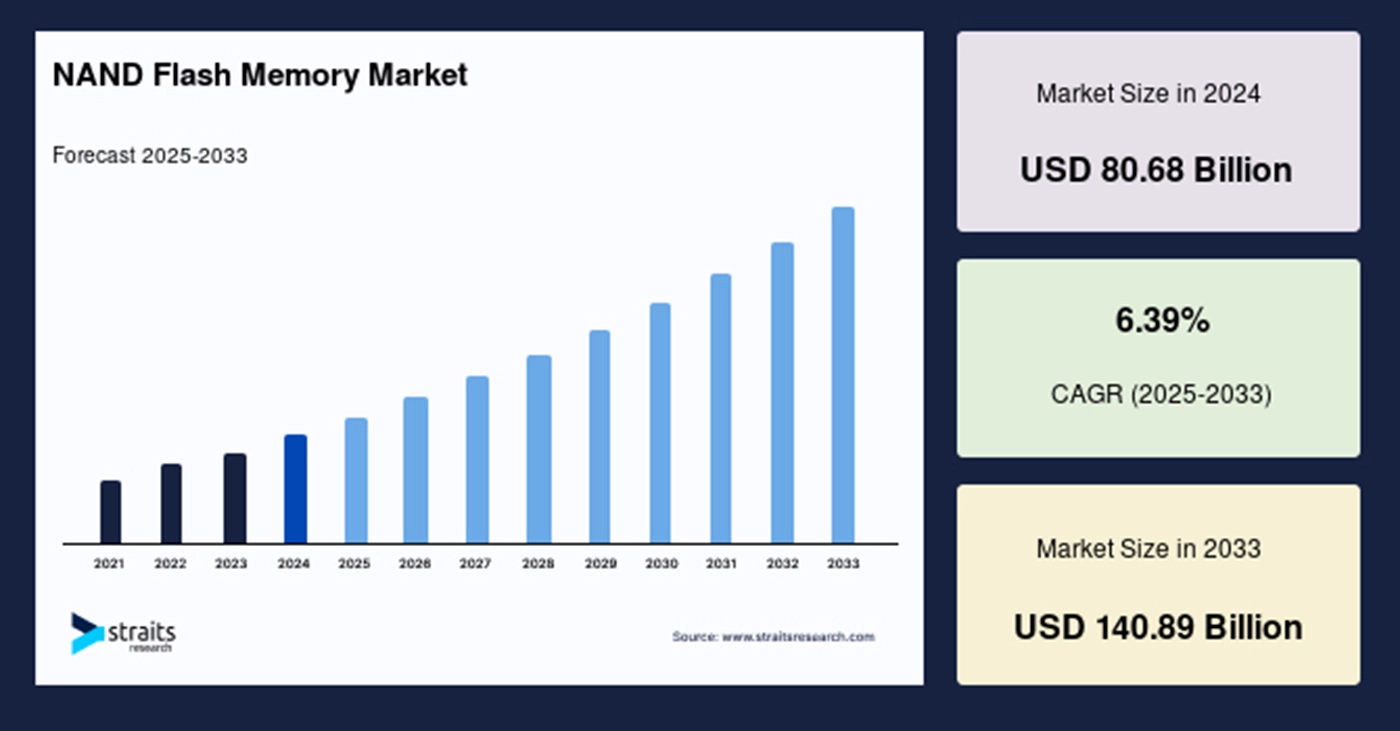

Dieses Wachstum unterstreicht, dass KI sowohl die Nachfrage nach High-End-SSDs als auch den Bit-Bedarf für NAND-Flash im Allgemeinen, was sich auf die Kapazitätsplanung und Preisgestaltung in der vorgelagerten Lieferkette auswirkt.

Auf der Angebotsseite sind sich die Speicherhersteller zunehmend der strukturellen Anforderungen der KI an Hochbreitenspeicher (HBM)DRAM und NAND. So erklärte beispielsweise ein großer Speicherhersteller im Jahr 2025, dass die KI-Nachfrage nach HBM und anderen Speichertypen eine wichtige Wachstumsvariable ist, was darauf hindeutet, dass die Lieferketten für Speicher und NAND von KI-Projekten beeinflusst werden, die möglicherweise Priorität haben.

Darüber hinaus bildet das Speicher-Ökosystem rund um KI neue Datenarchitekturen und Service-Ebenen. Vektordatenbanken als Kerninfrastruktur für das Retrieval und die semantische Suche sind in den Jahren 2024-2025 schnell gewachsen, und ihre Abhängigkeit von Nearline-Speicher (oft NVMe SSD) unterstreicht die zunehmende Bedeutung von SSD im KI-Stack. Zusammengenommen erhöht die KI-Skalierung nicht nur die "Kapazitäts"-Nachfrage, sondern auch die Anforderungen an Leistung (Durchsatz, IOPS, Latenz), Ausdauer (Schreibbeständigkeit) und Intelligenz (Firmware und rechnergestützter Speicher).

Wie KI-Workloads die technischen Metriken von SSDs neu definieren

Traditionell war die Auswahl von SSDs ein Kompromiss zwischen Kapazität, Kosten pro GB und sequenzieller Lese-/Schreibleistung. Aber KI-Arbeitslasten bringen neue Anforderungen mit sich, die diesen Dreiklang unzureichend machen.

In der Trainingsphase liegt der Schwerpunkt der Speichernachfrage auf einer großen Kapazität und einem hohen sequenziellen Durchsatz, wobei gleichzeitig eine sehr hohe parallele Bandbreite und eine dauerhafte Schreibfähigkeit erforderlich sind. Trainingsworkflows beinhalten häufige Checkpoint-Schreibvorgänge, verteiltes Speichern von Modell-Slices und eine massive Vorverarbeitung von Beispieldaten, die jeweils hohe Anforderungen an den Schreibdurchsatz und die Ausdauer stellen.

In Online-Inferenz- und RAG-Szenarien werden SSDs mit einer anderen Reihe von Anforderungen konfrontiert. Diese Szenarien beinhalten in der Regel viele kleine zufällige Lesevorgänge mit sehr geringer Latenz, insbesondere wenn Vektorindizes oder Einbettungen in mehrere Teile aufgeteilt sind und der Abruf Tausende von gleichzeitigen kleinen zufälligen E/A-Anforderungen erzeugt. Niedrige Latenzzeiten und hohe IOPS sind daher entscheidend für die Systemreaktion und die Benutzerfreundlichkeit. In vielen Fällen kann die DRAM-Zwischenspeicherung allein die Arbeitsmenge nicht abdecken, so dass NVMe-SSDs Die SSD muss daher eine hohe Random-Read-Leistung bieten und gleichzeitig ein Gleichgewicht zwischen Kosten und Kapazität herstellen.

Im Kontext des KI-Lebenszyklus erhöhen Praktiken wie inkrementelle Prüfpunkte, Feinabstimmung von Modellen und Synchronisierung von Parametern und Servern die Häufigkeit von Schreibvorgängen und verschärfen die Schreibverstärkung. Daher sind die Ausdauermetriken (z. B., TBW, DWPD) von SSDs werden wichtiger als nur der reine Durchsatz. SSD-Anbieter müssen fortschrittliche Flash-Translation-Layer-Algorithmen (FTL), intelligentere Garbage-Collection-Strategien und effizientere Schreibkonsolidierungsmechanismen einsetzen, um die Lebensdauer zu verlängern und die Leistung aufrechtzuerhalten.

Aus Sicht der Gesamtsystemarchitektur werden Verbindungstechnologien (z. B. PCIe 5.0/6.0, CXL) und verteilte Speicherprotokolle (wie NVMe-oF) zum Rückgrat der Verbindung zwischen SSDs und Rechenknoten. Ihre höhere Bandbreite und ihr geringerer Kommunikations-Overhead machen den Speicherzugriff bei groß angelegten Schulungen effizienter, was wiederum die Rolle von SSDs in der Architektur vorantreibt: Sie sind nicht mehr nur ein statischer Datenspeicher, sondern ein Echtzeit-Datenkanal, der eng mit dem Rechenzentrum gekoppelt ist.

Technologie-Roadmaps: Wie SSDs auf die neuen Anforderungen der KI reagieren

Als Reaktion auf die sich entwickelnden Anforderungen verfolgen SSD-Anbieter und Systemarchitekten klare Design-Richtungen. Erstens: Schnittstellen- und Protokoll-Upgrades sind von grundlegender Bedeutung. PCIe 5.0 wird bereits angenommen, und PCIe 6.0 wird voraussichtlich in den nächsten Jahren schrittweise eingeführt werden. Eine höhere Link-Bandbreite vergrößert direkt den maximal verfügbaren Durchsatz pro Laufwerk und verringert die Abhängigkeit von vielen parallelen Laufwerken, wodurch die Flexibilität der Systemintegration erhöht wird.

Bei der Wahl der NAND-Die müssen die Anbieter zwischen Kosten und Leistung abwägen. QLC und der kommende PLC-Multibit-Cell-NAND eignen sich dank ihrer geringeren Kosten und höheren Bitdichte gut für die kalte oder "warme" Datenspeicherung und unterstützen die wirtschaftliche Aufbewahrung großer Datenmengen. Gleichzeitig sind SLC/MLC-Typen - oder hochwertigere Enterprise-Grade-Dies - nach wie vor unverzichtbar für heiße Daten, die hohe IOPS und eine lange Lebensdauer erfordern. Viele Anbieter fügen daher größere DRAM- oder SLC-Cache-Bereiche in SSDs ein und wenden intelligentes Hot/Cold-Tiering an, so dass QLC auch in Szenarien mit vielen zufälligen Schreibvorgängen eine akzeptable Leistung erbringen kann.

Die Innovation von Controllern und Firmware wird noch wichtiger. Da die KI-Szenarien komplexere E/A-Muster erfordern, reichen herkömmliche Controller möglicherweise nicht mehr aus. Fortschrittlichere Controller können eine intelligentere Planung durchführen, Beschleunigung einbetten (z. B. Komprimierung/Dekomprimierung, Vorfilterung auf dem Laufwerk) und komplexere FTL-Routinen implementieren, um die Schreibkonsolidierung und Garbage Collection zu optimieren, wodurch die Schreibverstärkung reduziert und die Ausdauer verbessert wird.

Eine weitere bemerkenswerte Entwicklung ist die "computergestützte Speicherung" - die Einbettung spezialisierter Verarbeitungseinheiten in die SSD, so dass einige Berechnungen (z. B. Merkmalsextraktion, Vektorisierung, Vorfilterung) in der Nähe des Speichers selbst stattfinden können. Für die künstliche Intelligenz bedeutet dies, dass SSDs selbst eine erste Filterung oder Einbettung vornehmen können, was den Datenverkehr zwischen Host und Speicher reduziert und die End-to-End-Effizienz verbessert. Wenn diese Fähigkeit standardisiert wird und die Unterstützung durch das Software-Ökosystem ausgereift ist, könnte sie groß angelegte KI-Pipelines grundlegend umgestalten.

Neben Hardware und Protokollen ändert sich auch die Art und Weise, wie Speicher auf Systemebene integriert wird. So bietet beispielsweise CXL (Compute Express Link) eine Möglichkeit zur engeren Kopplung von Arbeitsspeicher und persistentem Speicher, wodurch auf Arbeitsspeicher- oder speicherähnliche Ressourcen dynamisch über Knoten hinweg zugegriffen werden kann - was beim Training großer KI-Modelle mit riesigen Parametermengen wichtig ist. Wenn sich CXL auf breiter Front durchsetzt, könnten sich die Positionierung und die erforderlichen Eigenschaften von SSDs ändern. In einigen Fällen könnten persistente Speicher (PMEM) oder Speicher der Speicherklasse (SCM) realisierbar werden, aber aufgrund der Kosten und der Reife des Ökosystems dürften NVMe-SSDs in absehbarer Zukunft die Vorherrschaft behalten.

Wie Vektordatenbanken, SDS und Datenverwaltung die SSD-Nutzung beeinflussen

Die Hardware bildet die Grundlage, aber der Schlüssel ist immer noch, wie die Software diese Hardware nutzt, um KI-Pipelines zu bedienen. In den letzten Jahren sind Vektordatenbanken, die den Kern der semantischen Suche und der RAG-Szenarien bilden, in den Jahren 2024-2025 mit rasantem Tempo gewachsen. Diese Datenbanken verwenden in der Regel eine "DRAM + NVMe SSD"-Speicherarchitektur, bei der heiße Vektoren im Arbeitsspeicher und größere Nearline-Vektorsätze auf NVMe SSD gespeichert werden, um Kosten und Reaktionsfähigkeit auszugleichen. Das Aufkommen von Vektordatenbanken hat die Bedeutung von NVMe-SSDs in Abrufszenarien direkt erhöht und die Anbieter dazu veranlasst, SSDs für Random-Read-Stabilität und geringe Latenz zu optimieren.

Gleichzeitig bieten Anbieter von Software-definiertem Speicher (SDS) hochleistungsfähige Blockspeicherdienste in Cloud- und Private-Cloud-Umgebungen an. SDS zeichnet sich dadurch aus, dass es die zugrundeliegenden SSD-Ressourcen orchestrieren kann, um QoS (Quality of Service), elastische Skalierung und feinkörniges Hot/Cold Data Tiering zu bieten - sehr nützlich für Plattformen, die Trainings- und Inferenz-Workloads gleichzeitig verarbeiten und gleichzeitig die Kosten kontrollieren müssen.

Eine weitere, oft übersehene Dimension sind Data Governance und Versionierungstools. In KI-Modellworkflows erzeugen zahlreiche Kontrollpunkte und Datensatzversionen (z. B. über DVC oder ähnliche Tools) unterschiedliche Schreibmuster. Dazu gehören regelmäßige Snapshot-Schreibvorgänge, verzweigte Datensätze und Audit-Protokolle, die allesamt zu Spitzen bei der Schreiblast führen. Für SSD-Anbieter und Systemarchitekten wird es notwendig, diese Schreibkurven zu modellieren und entsprechende Caching-Strategien zu entwickeln, um sicherzustellen, dass das System langfristig stabil arbeiten kann.

Angebot und Nachfrage und Marktdynamik

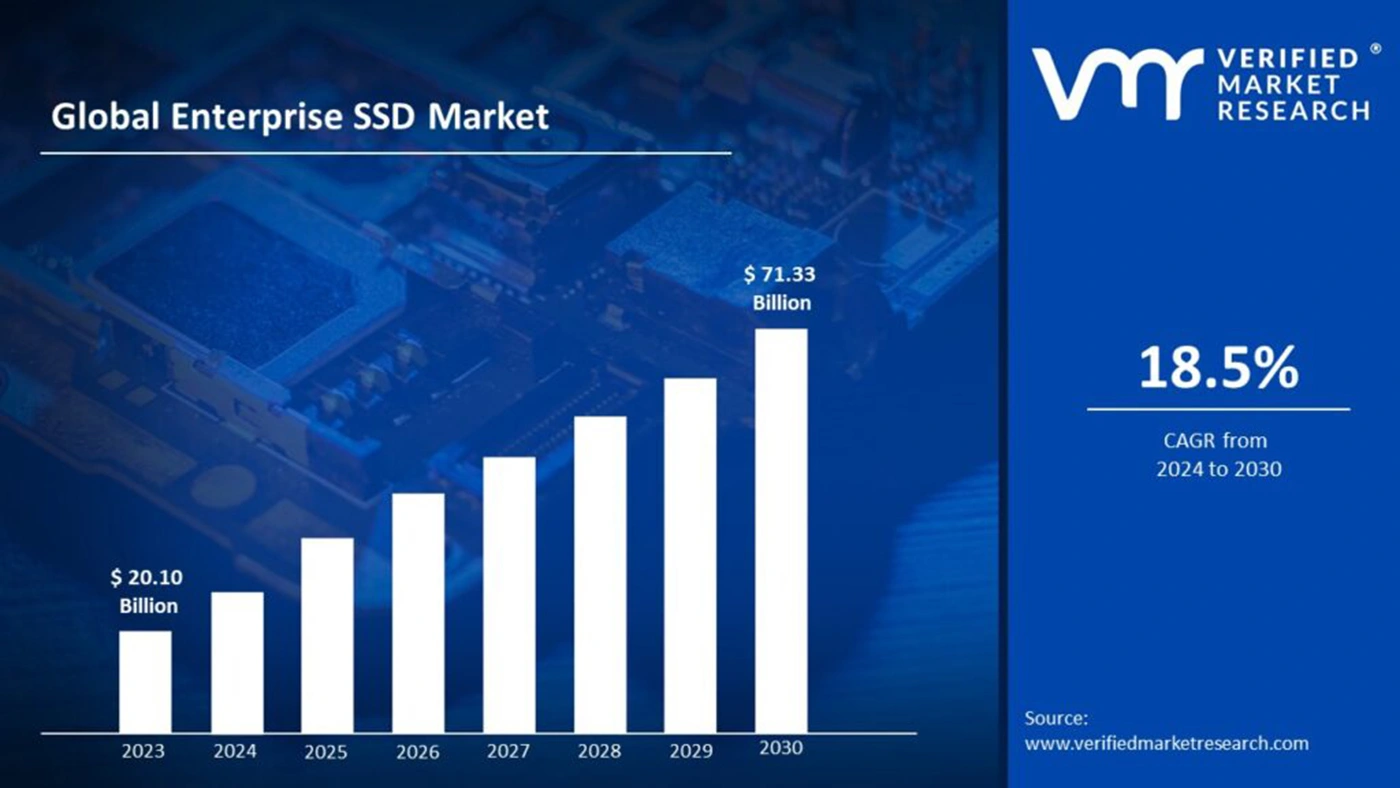

Die KI-Explosion rückt Arbeitsspeicher und Speicherressourcen wieder ins Rampenlicht und stellt NAND-Flash vor Herausforderungen beim Ausgleich von Angebot und Nachfrage. Branchenberichte und Nachrichtenartikel deuten darauf hin, dass die Anbieter von Arbeitsspeichern im Jahr 2025 die KI-Nachfrage nach HBM und anderen Speichertypen als eine Schlüsselvariable für das Umsatzwachstum betrachten. Obwohl HBM eher auf Beschleuniger abzielt, beeinflusst der steigende Druck auf die Speicher- und NAND-Nachfrage die Kostenstrukturen und Lieferfristen von SSDs.

Aus Sicht des Marktes zeigen die Umsatzprognosen für SSDs eine positive Entwicklung und einen steigenden Anteil für unternehmenstaugliche und KI-spezifische SSDs. Eine Prognose geht beispielsweise davon aus, dass die Größe des SSD-Marktes im Jahr 2025 55,73 Mrd. USD betragen und bis 2034 266,68 Mrd. USD erreichen wird.

Kapazitätserweiterungen sind jedoch kapitalintensiv und brauchen Zeit; jede Fehleinschätzung der künftigen Nachfrage kann zu einem Überangebot oder zu Engpässen führen, die beide Preisschwankungen verursachen. Diese Unwägbarkeiten zwingen die Marktteilnehmer zu einer vorsichtigeren Planung. Erschwerend kommen globale Risiken in der Versorgungskette hinzu: Geopolitische Spannungen, schwankende Rohstoffpreise und das Tempo der Investitionen in die Ausrüstung können sich alle auf die SSD-Freigabezyklen und die Lieferleistung auswirken. Die Anbieter müssen ein Gleichgewicht zwischen F&E-Investitionen und Kapazitätserweiterung herstellen: Sie müssen die künftige Eignung ihrer Produkte für KI-Szenarien sicherstellen und gleichzeitig die durch Überkapazitäten entstehenden Bestandsbelastungen vermeiden.

Risiken, Herausforderungen und drei wichtige Zukunftsperspektiven

Bei der Vorhersage künftiger Entwicklungen ist es wichtig, sich auf Unwägbarkeiten einzustellen. Erstens kann es länger dauern, bis Standards wie CXL und PCIe 6.0 auf breiter Basis angenommen werden als erwartet; wenn ihr Ökosystem langsam reift, kann sich die erwartete Entkopplung von Speicher und Arbeitsspeicher verzögern. Zweitens bleibt das tatsächliche Ausmaß des Einsatzes von Rechenspeichern abzuwarten; viele Szenarien beinhalten die Migration von Rechenlogik auf SSDs, was eine vollständige Software-Stack-Unterstützung und eine Koordinierung des Ökosystems erfordert - dies ist nichts, was Hardware-Anbieter allein erreichen können. Drittens können alternative Technologien (wie SCM, PMEM oder andere zukünftige nichtflüchtige Speicher) bei den Kosten oder der Leistung mit den aktuellen NAND-Lösungen gleichziehen, was die langfristigen SSD-Nachfrageprofile verändern würde.

Darüber hinaus werden Energieverbrauch und Nachhaltigkeit zunehmend an Bedeutung gewinnen. Das groß angelegte Training von Modellen der GPT-Klasse und der massive Einsatz von SSDs können den Energieverbrauch von Rechenzentren erheblich in die Höhe treiben. Über die Hardware-Effizienz hinaus muss die Branche in Messgrößen wie Leistung pro Watt und intelligentere Planung investieren, um die Anforderungen von Regulierungsbehörden und Unternehmen zu erfüllen.

Überblick über die Zeitachse: Wichtige Meilensteine und Entwicklung der Branche

| Zeit (nächste 3 Jahre) | Wichtiges Ereignis oder Trend | Besondere Auswirkungen auf die SSD-Industrie |

|---|---|---|

| 2024-2025 | Rasches Wachstum bei der Ausbildung von Modellen in ultragroßem Maßstab und Kommerzialisierung von Vektordatenbanken | Steigert die Nachfrage nach NVMe-SSDs mit hoher Kapazität und hohen IOPS-Geräten; beschleunigt kurzfristig die Expansion des SSD-Marktes für Unternehmen. |

| 2025 | Steigende Nachfrage nach HBM- und High-Bandwidth-Speicher; einige Speicherkapazitäten werden von KI-Projekten priorisiert | Engpässe bei der Versorgung mit Speicher und High-End-Chips können indirekt die Kosten für SSDs erhöhen und die Auslieferung verzögern. |

| 2025-2026 | Breitere Einführung von PCIe 5.0; schrittweise Etablierung von PCIe 6.0 und CXL-Ökosystemen | Erhöht die maximale Bandbreite pro Laufwerk und ermöglicht einen größeren parallelen Datenfluss; unterstützt flexiblere Speicherarchitekturen. |

| 2026-2027 | Erprobung und Einführung von rechnergestützter Speicherung und SDS in einigen Cloud- oder Edge-Szenarien | Wenn es zu einer signifikanten Reduzierung von End-to-End-Engpässen führt, wird es die gemeinsame Innovation von Speicher und Software fördern und die Positionierung von SSD neu gestalten. |

Die Rolle des SSD verlagert sich vom "Träger" zum "aktiven Teilnehmer".

Zusammenfassend lässt sich sagen, dass der Einfluss der KI auf die SSD-Branche im Jahr 2025 bereits mehr ist als nur eine Kapazitätserweiterung - es ist eine systematische Verschiebung, die Leistungsmetriken, Controller-/Firmware-Innovation, Software-Ökosystem-Zusammenarbeit und eine Neuausrichtung der Lieferkette berührt. SSDs entwickeln sich von relativ passiven Hardware-Gütern zu Schlüsselkomponenten, die aktiv an Datenverarbeitungs-Pipelines teilnehmen.

Der Aufstieg der KI bringt nicht nur größere Märkte und höhere Umsatzchancen mit sich, sondern auch eine tiefgreifende Überprüfung der SSD-Designphilosophie und der Kooperationsmodelle der Branche. In den nächsten drei bis fünf Jahren werden diejenigen, die bahnbrechende Innovationen bei Controllern, Firmware und softwaredefiniertem Speicher erreichen, wahrscheinlich die strukturelle Führung in einem KI-getriebenen Speichermarkt übernehmen. In einem sich schnell entwickelnden Technologie- und Marktumfeld wird die Kombination aus umsichtiger, aber proaktiver Strategie, ökosystemübergreifender Zusammenarbeit und Investitionen in langfristige technische Trends der Schlüssel zum Erfolg sein.