Em 2025, a inteligência artificial (IA) ultrapassou a fase inicial de experimentação e implementação inicial, entrando numa fase de aplicação alargada e de implantação industrial em grande escala. Quer se trate do treino de modelos de escala ultra grande ou da inferência de baixa latência em aplicações empresariais, os cenários de utilização da IA e os volumes de dados estão a crescer de forma explosiva. Esta onda de crescimento não só está a transformar a estrutura dos recursos de computação, como também está a remodelar profundamente o perfil de procura da camada de armazenamento - especialmente unidades de estado sólido (SSDs). Como componente essencial para a leitura e persistência de dados, as SSD já não são apenas módulos passivos de "capacidade"; estão a tornar-se elementos críticos de desempenho e inteligência ao nível do sistema.

O contexto: Como o aumento de escala da IA impulsiona a procura de armazenamento

Nos últimos anos, a dimensão dos modelos de IA e a computação necessária para o treino cresceram a um ritmo espantoso. De acordo com o Relatório do Índice de IA 2025 Segundo a Stanford HAI, a computação de treino de modelos de IA notáveis tem vindo a duplicar em períodos de tempo cada vez mais curtos e as dimensões dos conjuntos de dados estão também a aumentar rapidamente, o que significa que o treino de um modelo de IA de grandes dimensões exige agora exponencialmente mais recursos de armazenamento, largura de banda e persistência. Mais importante ainda, estes modelos de grande escala passaram de ambientes de desenvolvimento para cenários de implementação empresarial alargada e de inferência online, impulsionando a procura real de sistemas de armazenamento de baixa latência e elevada simultaneidade.

Para colocar isso em perspetiva: o treinamento em nuvem requer dados brutos em nível de petabyte e centenas de terabytes a petabytes de pesos de modelo, enquanto os cenários de inferência e geração aumentada de recuperação (RAG) introduzem milhares de pequenas solicitações de E/S aleatórias e leituras simultâneas elevadas. Essas tendências desafiam as SSDs de uma forma que o simples aumento da capacidade não pode resolver.

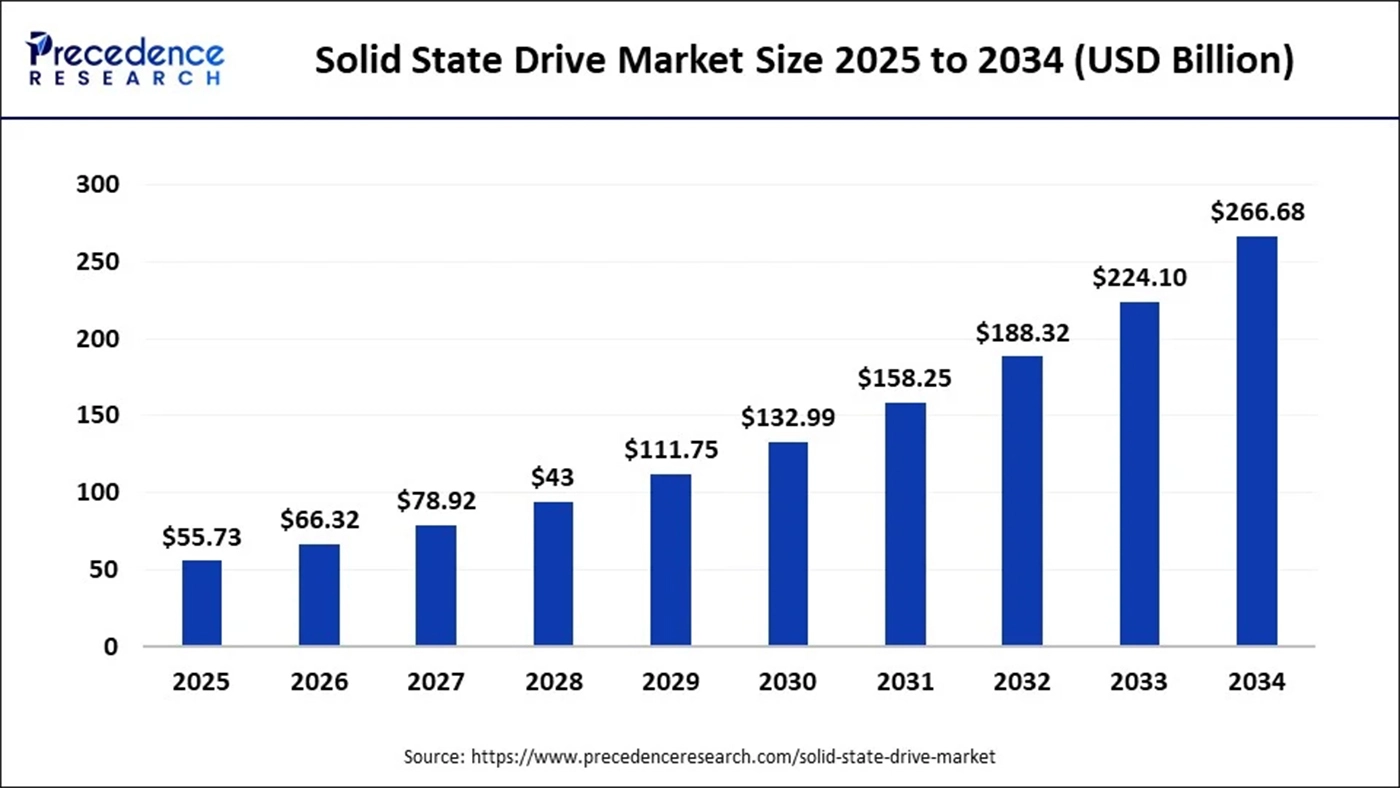

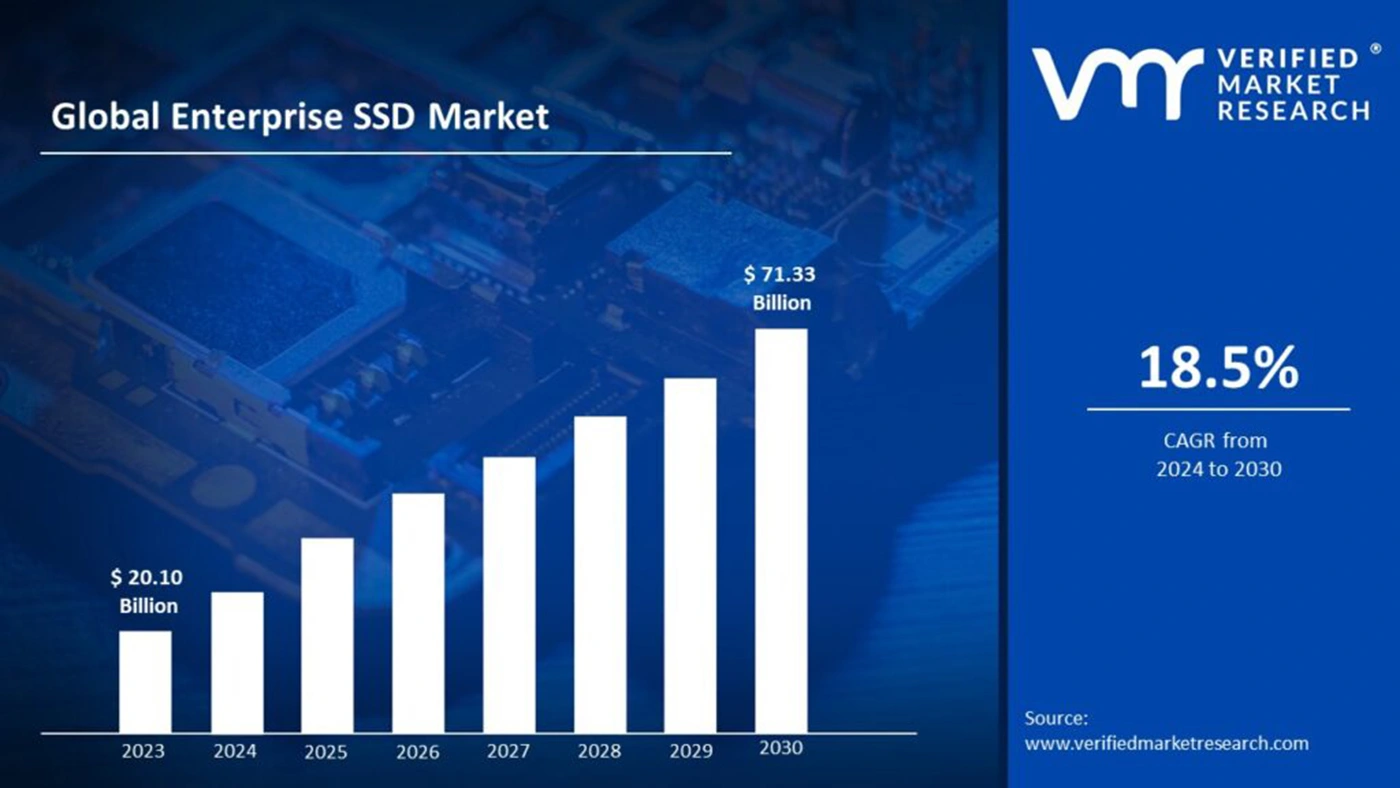

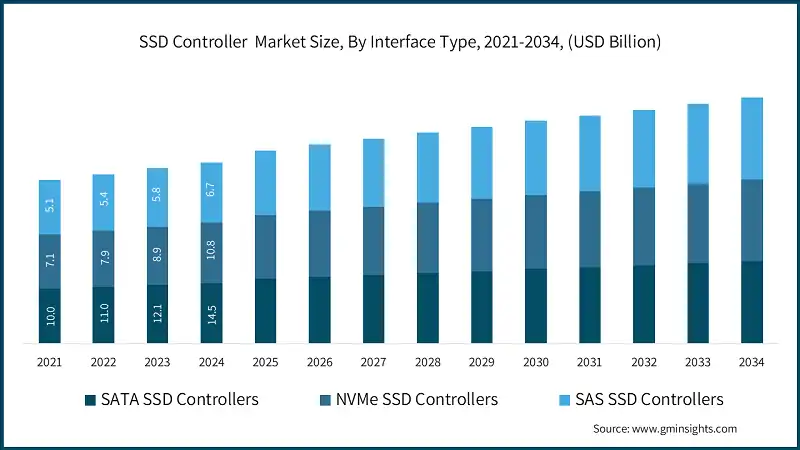

Entretanto, as previsões das empresas de estudos de mercado para o mercado dos SSD reflectem a IA como um importante motor de crescimento. Por exemplo, uma previsão mostra que o tamanho do mercado global de SSD em 2025 será de aproximadamente 55,73 mil milhões de dólarescom as projecções a subirem para cerca de 266,68 mil milhões de dólares até 2034.

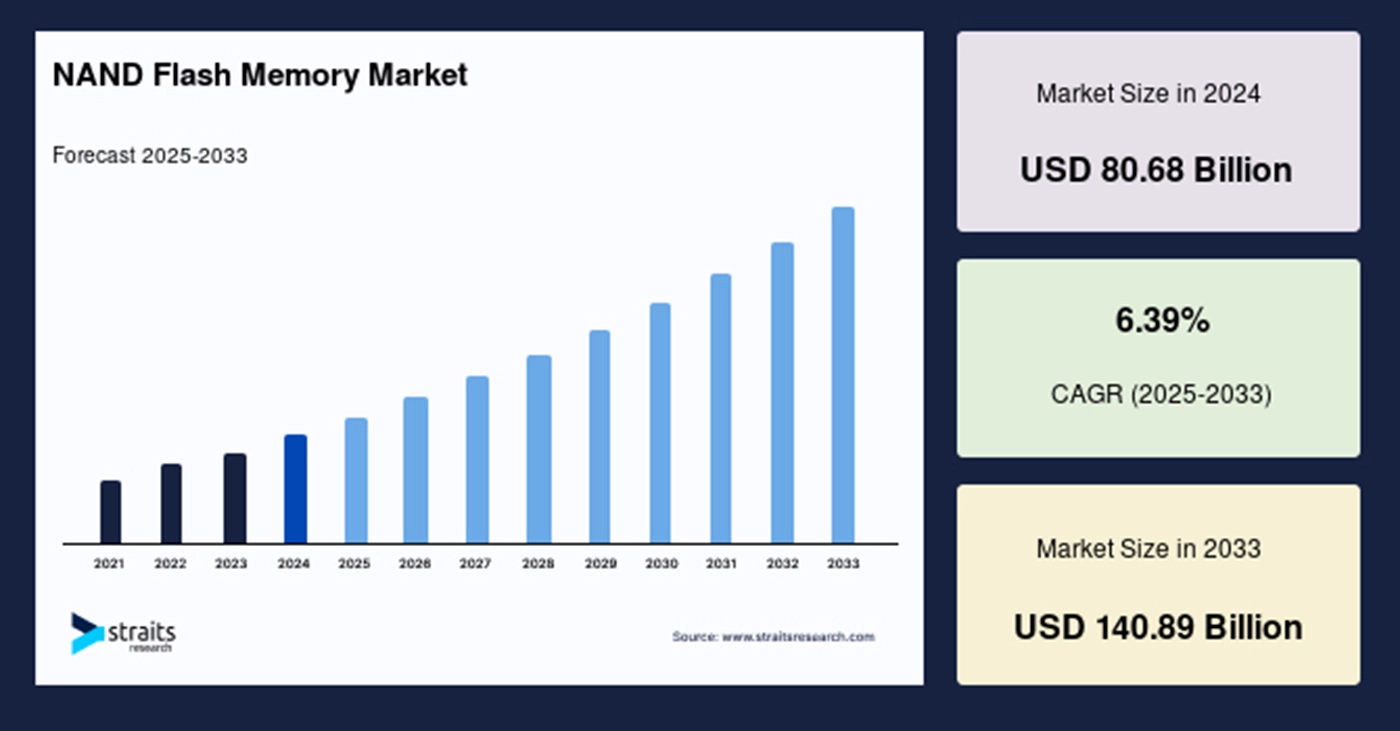

Este crescimento sublinha que a IA está a aumentar tanto a procura de SSD topo de gama como a procura de bits para Flash NAND em geral, o que afecta o planeamento da capacidade e a fixação de preços da cadeia de abastecimento a montante.

Do lado da oferta, os fornecedores de memória estão cada vez mais conscientes das exigências estruturais da IA para memória de alta largura de banda (HBM)DRAM e NAND. Por exemplo, um importante fornecedor de memórias declarou em 2025 que a procura de HBM e de outros tipos de memória por parte da IA é uma variável de crescimento fundamental, indicando que as cadeias de abastecimento de memória e NAND estão a ser afectadas por projectos de IA que podem ter prioridade.

Além disso, o ecossistema de armazenamento em torno da IA está formando novas arquiteturas de dados e camadas de serviço. Os bancos de dados vetoriais como infraestrutura central para recuperação e pesquisa semântica cresceram rapidamente em 2024-2025, e sua dependência de armazenamento próximo à linha (geralmente SSD NVMe) ressalta a importância crescente do SSD na pilha de IA. Em conjunto, o aumento de escala da IA não está simplesmente aumentando a demanda de "capacidade" - está elevando os requisitos de desempenho (throughput, IOPS, latência), resistência (durabilidade de gravação) e inteligência (firmware e armazenamento habilitado para computação).

Como as cargas de trabalho de IA redefinem as métricas técnicas de SSD

Tradicionalmente, a seleção de SSD tem sido um compromisso entre capacidade, custo por GB e desempenho de leitura/escrita sequencial. Mas as cargas de trabalho de IA trazem novas exigências que tornam essa tríade insuficiente.

Na fase de treinamento, a demanda de armazenamento enfatiza a grande capacidade e o alto rendimento seqüencial - mas ao mesmo tempo requer uma largura de banda paralela muito alta e capacidade de gravação persistente. Os fluxos de trabalho de treinamento envolvem gravações freqüentes de pontos de verificação, salvamento distribuído de fatias de modelos e pré-processamento maciço de dados de amostra - cada um dos quais impõe grandes demandas de taxa de transferência e resistência de gravação.

Nos cenários de inferência em linha e RAG, os SSDs enfrentam um conjunto diferente de exigências. Estes cenários envolvem normalmente muitas leituras aleatórias pequenas com latência muito baixa, especialmente quando os índices vectoriais ou os embeddings são fragmentados e a recuperação gera milhares de pedidos de E/S aleatórios pequenos e simultâneos. A baixa latência e o elevado IOPS tornam-se assim críticos para a resposta do sistema e a experiência do utilizador. Em muitas implantações reais, o cache DRAM sozinho não pode cobrir o conjunto de trabalho, tornando SSDs NVMe o nível necessário para o armazenamento quase em linha; o SSD deve, por conseguinte, manter um elevado desempenho de leitura aleatória, equilibrando simultaneamente o custo e a capacidade.

Além disso, no contexto do ciclo de vida da IA, práticas como pontos de controlo incrementais, afinação de modelos e sincronização parâmetro-servidor aumentam a frequência das escritas e exacerbam a amplificação da escrita. Assim, as métricas de resistência (por exemplo, TBW, DWPD) dos SSDs tornam-se mais importantes do que simplesmente o rendimento bruto. Os fornecedores de SSD têm de adotar algoritmos avançados da Camada de Tradução Flash (FTL), estratégias de recolha de lixo mais inteligentes e mecanismos de consolidação de escrita mais eficientes para prolongar a vida útil e manter o desempenho.

Do ponto de vista da arquitetura geral do sistema, as tecnologias de interligação (por exemplo, PCIe 5.0/6.0, CXL) e os protocolos de armazenamento distribuído (como o NVMe-oF) estão a tornar-se a espinha dorsal que liga os SSD aos nós de computação. A sua maior largura de banda e menor sobrecarga de comunicação tornam o acesso ao armazenamento mais eficiente na formação em grande escala, o que, por sua vez, aumenta o papel dos SSD na arquitetura: já não se trata apenas de um armazenamento de dados estático, mas de um canal de dados em tempo real estreitamente ligado à computação.

Roteiros tecnológicos: Como os SSDs respondem às novas necessidades da IA

Em resposta à evolução das exigências, os fornecedores de SSD e os arquitectos de sistemas estão a seguir orientações claras em termos de design. Primeiro, as atualizações de interface e protocolo são fundamentais. O PCIe 5.0 já está sendo adotado, e PCIe 6.0 deverá ser lançado gradualmente ao longo dos próximos anos. Uma maior largura de banda de ligação aumenta diretamente o débito máximo disponível por unidade e reduz a dependência de muitas unidades paralelas, aumentando assim a flexibilidade de integração do sistema.

Em termos de escolha de matrizes NAND, os fornecedores devem ponderar o custo e o desempenho. QLC e a futura NAND de células multi-bit PLC, graças ao seu custo mais baixo e maior densidade de bits, são adequadas para o armazenamento de dados frios ou "quentes", suportando a retenção económica de dados em grande escala. Simultaneamente, os tipos SLC/MLC - ou matrizes de nível empresarial de topo de gama - continuam a ser essenciais para dados quentes que exigem IOPS elevados e uma vida útil longa. Por isso, muitos fornecedores acrescentam áreas de cache DRAM ou SLC maiores nas SSDs e aplicam uma classificação inteligente em camadas quente/fria para que a QLC ainda possa ter um desempenho aceitável em cenários com muitas gravações aleatórias.

A inovação do controlador e do firmware torna-se ainda mais crítica. Como os cenários de IA impõem padrões de E/S mais complexos, os controladores tradicionais podem já não ser suficientes. Os controladores mais avançados podem efetuar um agendamento mais inteligente, incorporar aceleração (por exemplo, compressão/descompressão, pré-filtragem na unidade) e implementar rotinas FTL mais complexas para otimizar a consolidação de escrita e a recolha de lixo, reduzindo assim a amplificação da escrita e melhorando a resistência.

Outro desenvolvimento digno de nota é o "armazenamento computacional" - incorporando unidades de processamento especializadas dentro do SSD para que alguma computação (por exemplo, extração de recursos, vetorização, pré-filtragem) possa ocorrer perto do próprio armazenamento. Para a IA, isso significa que os próprios SSDs podem realizar a filtragem inicial ou a geração de incorporação, reduzindo a movimentação de dados entre o host e o armazenamento e melhorando a eficiência de ponta a ponta. Se esse recurso se tornar padronizado e o suporte do ecossistema de software amadurecer, ele poderá remodelar profundamente os pipelines de IA em grande escala.

Para além do hardware e dos protocolos, a forma como o armazenamento é integrado ao nível do sistema também está a mudar. Por exemplo, o CXL (Compute Express Link) oferece uma forma de acoplar mais fortemente a memória e o armazenamento persistente, tornando os recursos de memória ou quase-memória dinamicamente acessíveis entre nós - importante ao treinar grandes modelos de IA com enormes volumes de parâmetros. Se o CXL for amplamente adotado, o posicionamento e as caraterísticas necessárias dos SSDs podem mudar; em alguns casos, a memória persistente (PMEM) ou a memória de classe de armazenamento (SCM) podem se tornar viáveis, mas devido ao custo e à maturidade do ecossistema, espera-se que os SSDs NVMe mantenham o domínio no futuro próximo.

Como os bancos de dados vetoriais, o SDS e a governança de dados afetam o uso de SSD

O hardware estabelece as bases, mas a chave continua a ser a forma como o software tira partido desse hardware para servir os pipelines de IA. Nos últimos anos, as bases de dados vectoriais, como o núcleo da pesquisa semântica e dos cenários RAG, cresceram a um ritmo alucinante em 2024-2025. Esses bancos de dados geralmente adotam uma arquitetura de armazenamento em camadas "DRAM + NVMe SSD", mantendo vetores quentes na memória e conjuntos de vetores maiores e quase em linha no NVMe SSD para equilibrar custo e capacidade de resposta. O aumento dos bancos de dados vetoriais aumentou diretamente a importância dos SSDs NVMe em cenários de recuperação e levou os fornecedores a otimizar os SSDs para estabilidade de leitura aleatória e baixa latência.

Ao mesmo tempo, os fornecedores de armazenamento definido por software (SDS) estão a oferecer serviços de armazenamento em bloco de alto desempenho em configurações de nuvem e nuvem privada. O SDS destaca-se porque pode orquestrar recursos SSD subjacentes para fornecer QoS (qualidade de serviço), escalonamento elástico e camadas de dados quentes/frias de grão mais fino - muito útil para plataformas que precisam de lidar com cargas de trabalho de formação e inferência em simultâneo, controlando simultaneamente os custos.

Outra dimensão frequentemente negligenciada é a governação dos dados e as ferramentas de controlo de versões. Nos fluxos de trabalho de modelos de IA, vários pontos de verificação e versões de conjuntos de dados (por exemplo, via DVC ou ferramentas semelhantes) geram padrões de gravação distintos. Isso inclui gravações periódicas de instantâneos, conjuntos de dados ramificados e logs de auditoria - tudo isso leva a picos de carga de gravação. Para os fornecedores de SSDs e arquitetos de sistemas, modelar essas curvas de gravação e projetar as estratégias de cache correspondentes torna-se necessário para garantir que o sistema possa operar de forma estável a longo prazo.

Oferta e procura e dinâmica do mercado

A explosão da IA está a colocar novamente os recursos de memória e armazenamento no centro das atenções, colocando desafios de equilíbrio entre a oferta e a procura para o flash NAND. Os relatórios da indústria e os artigos de notícias indicam que os fornecedores de memória em 2025 estão a tratar a procura de HBM e de outros tipos de memória por parte da IA como uma variável fundamental para o crescimento das receitas. Embora o HBM seja mais diretamente direcionado para aceleradores, a pressão ascendente sobre a procura de memória e NAND influencia as estruturas de custos e os prazos de entrega dos SSDs.

Do ponto de vista do mercado, as previsões de receita de SSD mostram trajetórias positivas e uma participação crescente de SSDs de nível empresarial e específicos para IA. Por exemplo, uma previsão coloca o tamanho do mercado de SSDs em US$ 55,73 bilhões em 2025, atingindo US$ 266,68 bilhões em 2034.

No entanto, a expansão da capacidade é de capital intensivo e leva tempo; qualquer estimativa incorrecta da procura futura pode levar a um excesso de oferta ou a uma escassez, o que provoca oscilações de preços. Estas incertezas significam que os participantes na indústria devem adotar um planeamento mais cauteloso. A complicar ainda mais esta situação estão os riscos globais da cadeia de fornecimento - as tensões geopolíticas, a volatilidade dos preços das matérias-primas e o ritmo de investimento em equipamento podem afetar os ciclos de lançamento de SSD e o desempenho da entrega. Os fornecedores precisam equilibrar o investimento em P&D e a expansão da capacidade: garantir a adequação futura dos produtos aos cenários de IA e, ao mesmo tempo, evitar os encargos de estoque decorrentes do excesso de capacidade

Riscos, desafios e três pontos de observação fundamentais para o futuro

Ao prever os desenvolvimentos futuros, é fundamental manter a sensibilidade às incertezas. Em primeiro lugar, normas como a CXL e a PCIe 6.0 podem levar mais tempo do que o esperado para serem amplamente adoptadas; se o seu ecossistema amadurecer lentamente, a esperada dissociação entre memória e armazenamento pode ser atrasada. Em segundo lugar, a escala real de implantação do armazenamento computacional ainda está por ver; muitos cenários envolvem a migração da lógica de computação para SSDs, o que exige suporte total da pilha de software e coordenação do ecossistema - o que não é algo que os fornecedores de hardware possam conseguir sozinhos. Em terceiro lugar, as tecnologias alternativas (como SCM, PMEM ou outras futuras memórias não voláteis) podem alcançar as soluções NAND actuais em termos de custo ou desempenho, o que alteraria os perfis de procura de SSD a longo prazo.

Além disso, o consumo de energia e a sustentabilidade tornar-se-ão cada vez mais importantes. A formação em larga escala de modelos de classe GPT e as implementações maciças de SSD podem aumentar significativamente o consumo de energia dos centros de dados. Além da eficiência do hardware, o setor precisa investir em métricas como desempenho por watt e programação mais inteligente para atender às demandas regulatórias e de ESG das empresas.

Resumo da cronologia: Principais marcos e evolução do sector

| Tempo (próximos 3 anos) | Evento-chave ou tendência | Impacto específico no sector dos SSD |

|---|---|---|

| 2024-2025 | Crescimento rápido do treino de modelos em escala ultra-grande e comercialização de bases de dados de vectores | Aumenta a procura de SSD NVMe de elevada capacidade e de dispositivos de elevado IOPS; a curto prazo, acelera a expansão do mercado de SSD para empresas. |

| 2025 | Aumento da procura de HBM e de memória de elevada largura de banda; alguns projectos de IA dão prioridade à capacidade de memória | As restrições no fornecimento de memória e de chips topo de gama podem aumentar indiretamente os custos dos SSD e atrasar as entregas. |

| 2025-2026 | Maior implantação do PCIe 5.0; estabelecimento gradual dos ecossistemas PCIe 6.0 e CXL | Aumenta a largura de banda máxima por unidade e permite um maior fluxo de dados paralelo; suporta arquitecturas de armazenamento mais flexíveis. |

| 2026-2027 | Ensaio e implantação de armazenamento computacional e SDS em alguns cenários de computação em nuvem ou periféricos | Se conseguir uma redução significativa dos estrangulamentos de ponta a ponta, promoverá uma maior co-inovação entre armazenamento e software e reformulará o posicionamento dos SSD. |

O papel da SSD está a mudar de "transportadora" para "participante ativa"

Em resumo, o impacto da IA na indústria de SSDs em 2025 já é mais do que simplesmente impulsionar a expansão da capacidade - é uma mudança sistemática que toca as métricas de desempenho, a inovação do controlador/firmware, a colaboração do ecossistema de software e o realinhamento da cadeia de suprimentos. As SSDs estão evoluindo de commodities de hardware relativamente passivas para componentes-chave que participam ativamente dos pipelines de processamento de dados.

A ascensão da IA traz não apenas mercados maiores e oportunidades de maior receita, mas também uma profunda introspeção na filosofia de design de SSD e nos modelos de colaboração do setor. Nos próximos três a cinco anos, aqueles que conseguirem inovações revolucionárias em controladores, firmware e armazenamento definido por software provavelmente assumirão a liderança estrutural em um mercado de armazenamento impulsionado por IA. Num ambiente tecnológico e de mercado em rápida evolução, a combinação de uma estratégia prudente mas proactiva, a cooperação entre ecossistemas e o investimento em tendências técnicas a longo prazo serão a chave do sucesso.