Nel 2025, l'intelligenza artificiale (AI) ha superato la fase iniziale di sperimentazione e di lancio, entrando in una fase di ampia applicazione e di diffusione industriale su larga scala. Che si tratti dell'addestramento di modelli su larghissima scala o dell'inferenza a bassa latenza nelle applicazioni aziendali, gli scenari di utilizzo e i volumi di dati dell'IA stanno crescendo in modo esplosivo. Questa ondata di crescita non solo sta trasformando la struttura delle risorse di calcolo, ma sta anche rimodellando profondamente il profilo della domanda del livello di storage, in particolare unità a stato solido (SSD). Come componente chiave per la lettura e la persistenza dei dati, le unità SSD non sono più solo moduli passivi di "capacità", ma stanno diventando elementi critici per le prestazioni e l'intelligenza del sistema.

Il contesto: Come la scalabilità dell'intelligenza artificiale determina la domanda di storage

Negli ultimi anni, le dimensioni dei modelli di intelligenza artificiale e i calcoli necessari per l'addestramento sono cresciuti a ritmi sorprendenti. Secondo il rapporto sull'indice AI 2025 da Stanford HAI, il calcolo per l'addestramento di importanti modelli di intelligenza artificiale è raddoppiato in tempi sempre più brevi e anche le dimensioni dei set di dati sono in rapida espansione, il che significa che l'addestramento di un modello di intelligenza artificiale di grandi dimensioni richiede ora un numero esponenzialmente maggiore di risorse di archiviazione, larghezza di banda e persistenza. Inoltre, questi modelli su larga scala sono passati da ambienti di sviluppo a scenari di distribuzione aziendale e di inferenza online, con conseguente richiesta di sistemi di storage a bassa latenza e alta liquidità.

Per intenderci: l'addestramento nel cloud richiede dati grezzi di livello petabyte e centinaia di terabyte o petabyte di pesi del modello, mentre l'inferenza e gli scenari di retrieval-augmented generation (RAG) introducono migliaia di piccole richieste di I/O casuali ed elevate letture simultanee. Queste tendenze mettono a dura prova le unità SSD in modi che il semplice aumento della capacità non è in grado di affrontare.

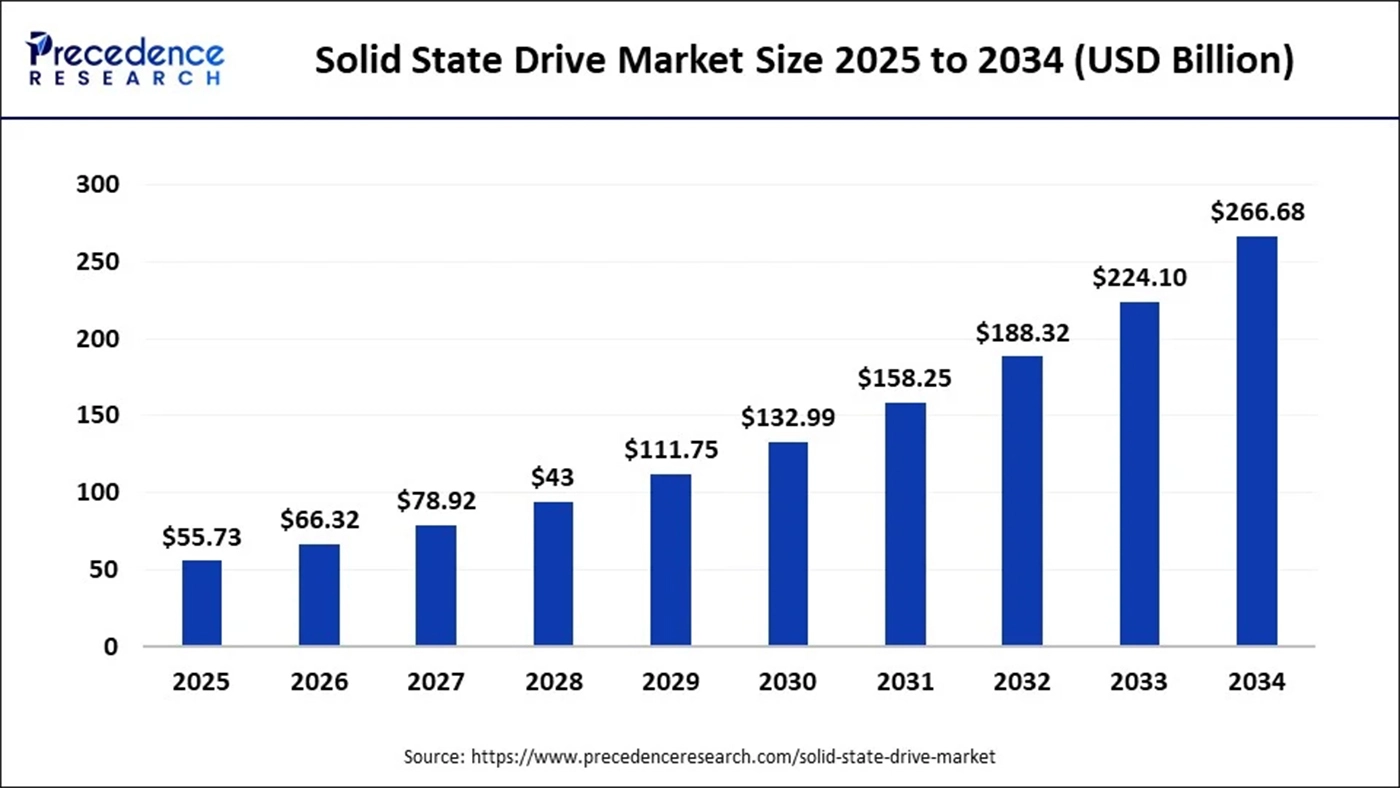

Nel frattempo, le previsioni delle società di ricerca di mercato per il mercato delle unità SSD indicano l'intelligenza artificiale come uno dei principali fattori di crescita. Ad esempio, una previsione indica che le dimensioni del mercato globale delle SSD nel 2025 saranno circa 55,73 miliardi di dollari, con proiezioni che salgono a circa 266,68 miliardi di dollari entro il 2034.

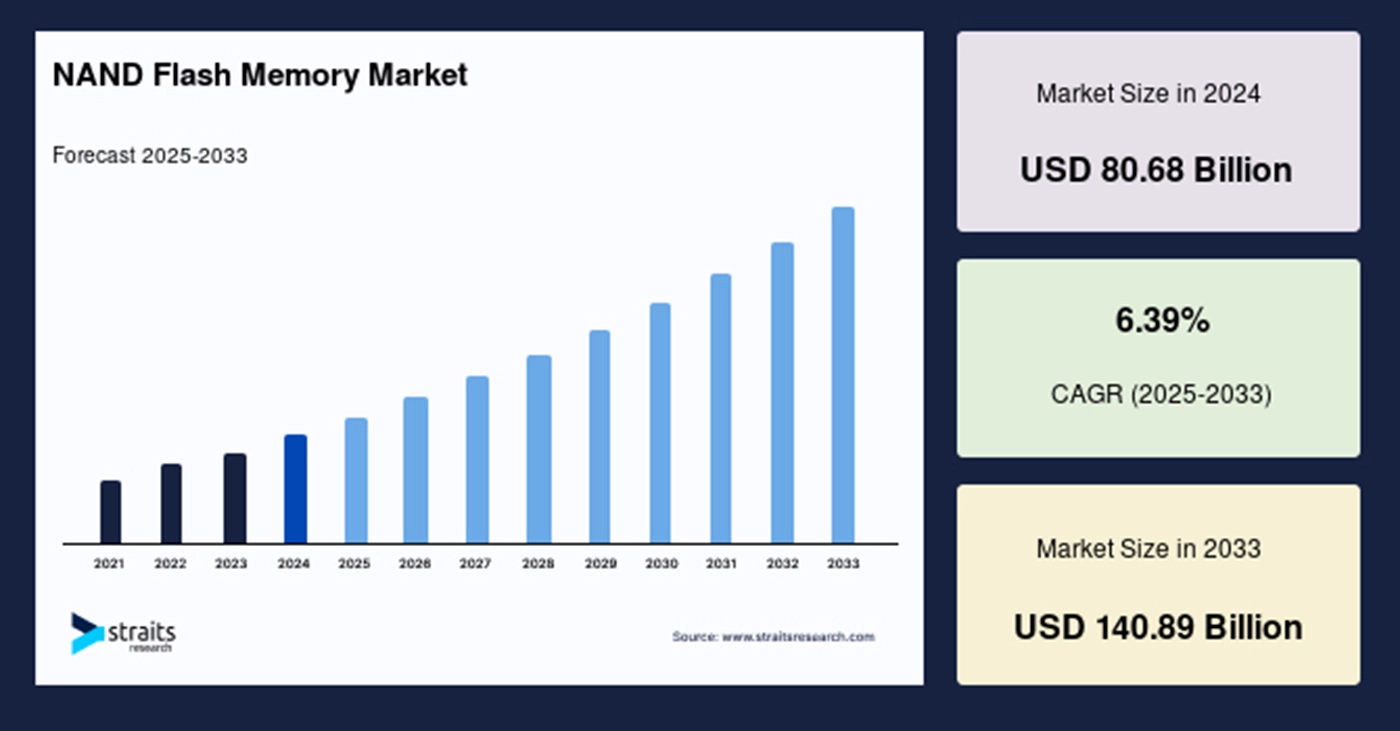

Questa crescita sottolinea che l'intelligenza artificiale sta aumentando sia la domanda di unità SSD di fascia alta che la domanda di bit per le unità SSD. Flash NAND in generale, che influisce sulla pianificazione della capacità della catena di approvvigionamento a monte e sulla determinazione dei prezzi.

Dal punto di vista dell'offerta, i fornitori di memorie sono sempre più consapevoli delle esigenze strutturali dell'IA in termini di memoria ad alta larghezza di banda (HBM)DRAM e NAND. Ad esempio, un importante fornitore di memorie nel 2025 ha dichiarato che la domanda di IA per HBM e altri tipi di memoria è una variabile di crescita fondamentale, indicando che le catene di fornitura di memorie e NAND sono influenzate da progetti di IA che possono avere la priorità.

Inoltre, l'ecosistema di storage attorno all'IA sta formando nuove architetture di dati e livelli di servizio. I database vettoriali come infrastruttura di base per il reperimento e la ricerca semantica sono cresciuti rapidamente nel 2024-2025 e la loro dipendenza dallo storage near-line (spesso SSD NVMe) sottolinea la crescente importanza delle SSD nello stack dell'IA. Nel complesso, la scalata dell'IA non sta semplicemente aumentando la domanda di "capacità", ma sta elevando i requisiti in termini di prestazioni (throughput, IOPS, latenza), resistenza (durata della scrittura) e intelligenza (firmware e storage abilitato al calcolo).

Come i carichi di lavoro AI ridefiniscono le metriche tecniche delle unità SSD

Tradizionalmente, la scelta delle unità SSD si basa su un compromesso tra capacità, costo per GB e prestazioni di lettura/scrittura sequenziale. Ma i carichi di lavoro dell'intelligenza artificiale comportano nuove esigenze che rendono questa triade insufficiente.

Nella fase di addestramento, la domanda di storage enfatizza la grande capacità e l'elevato throughput sequenziale, ma allo stesso tempo richiede una larghezza di banda parallela molto elevata e una capacità di scrittura persistente. I flussi di lavoro per l'addestramento comportano frequenti scritture di checkpoint, il salvataggio distribuito di fette di modello e una massiccia pre-elaborazione di dati campione, ognuno dei quali impone pesanti requisiti di throughput di scrittura e di resistenza.

Negli scenari di inferenza online e RAG, le unità SSD devono affrontare una serie di requisiti diversi. Questi scenari comportano in genere molte piccole letture casuali con una latenza molto bassa, soprattutto quando gli indici vettoriali o gli embeddings sono shardati e il recupero genera migliaia di piccole richieste di I/O casuali simultanee. Bassa latenza e IOPS elevato diventano quindi fondamentali per la risposta del sistema e l'esperienza dell'utente. In molte implementazioni reali, la cache DRAM da sola non è in grado di coprire l'insieme di lavoro, il che rende SSD NVMe L'SSD deve quindi mantenere elevate prestazioni in lettura casuale, bilanciando al contempo costi e capacità.

Inoltre, nel contesto del ciclo di vita dell'intelligenza artificiale, pratiche come i checkpoint incrementali, la messa a punto dei modelli e la sincronizzazione tra parametri e server aumentano la frequenza delle scritture e aggravano l'amplificazione della scrittura. Pertanto, le metriche di resistenza (ad esempio, TBW, DWPD) delle unità SSD diventano più importanti del semplice throughput grezzo. I fornitori di SSD devono adottare algoritmi avanzati di Flash Translation Layer (FTL), strategie di garbage collection più intelligenti e meccanismi di consolidamento della scrittura più efficienti per prolungare la durata e sostenere le prestazioni.

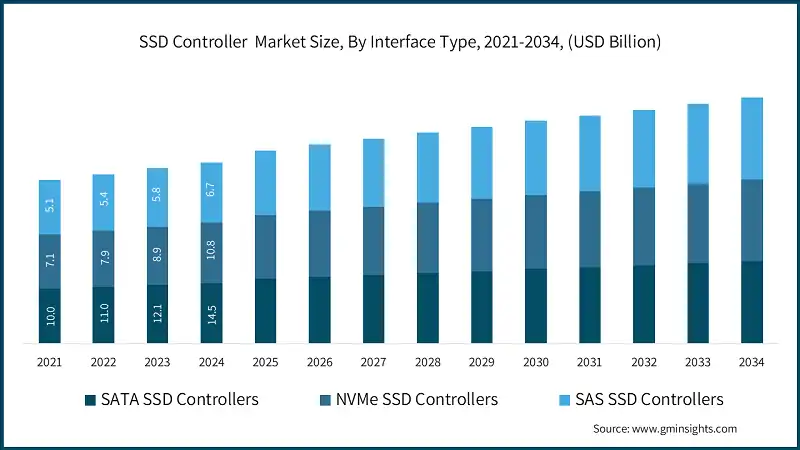

Dal punto di vista dell'architettura generale del sistema, le tecnologie di interconnessione (ad esempio, PCIe 5.0/6.0, CXL) e i protocolli di archiviazione distribuita (come NVMe-oF) stanno diventando la spina dorsale che collega gli SSD ai nodi di calcolo. La loro maggiore larghezza di banda e il minore overhead di comunicazione rendono l'accesso allo storage più efficiente nella formazione su larga scala, il che a sua volta spinge il ruolo degli SSD nell'architettura: non più solo un archivio statico di dati, ma un canale di dati in tempo reale strettamente accoppiato all'elaborazione.

Roadmap tecnologiche: Come le unità SSD rispondono alle nuove esigenze dell'IA

In risposta all'evoluzione della domanda, i fornitori di SSD e gli architetti di sistema stanno seguendo chiare indicazioni di progettazione. In primo luogo, gli aggiornamenti delle interfacce e dei protocolli sono fondamentali. PCIe 5.0 è già stato adottato e PCIe 6.0 è previsto il lancio graduale nei prossimi anni. Una maggiore larghezza di banda dei collegamenti aumenta direttamente il throughput massimo disponibile per unità e riduce la dipendenza da molte unità parallele, aumentando così la flessibilità di integrazione del sistema.

Per quanto riguarda la scelta del die NAND, i produttori devono valutare i costi rispetto alle prestazioni. QLC e le prossime NAND PLC a più celle di bit, grazie al loro costo inferiore e alla maggiore densità di bit, sono adatte per l'archiviazione di dati a freddo o "caldi", supportando la conservazione economica dei dati su larga scala. Allo stesso tempo, i tipi SLC/MLC o i dies di fascia alta di livello enterprise rimangono essenziali per i dati a caldo che richiedono IOPS elevati e lunga durata. Molti produttori aggiungono quindi aree di cache DRAM o SLC più grandi all'interno delle unità SSD e applicano un tiering intelligente caldo/freddo, in modo che il QLC possa ancora fornire prestazioni accettabili in scenari con scritture casuali pesanti.

L'innovazione dei controller e del firmware diventa ancora più critica. Poiché gli scenari di intelligenza artificiale impongono modelli di I/O più complessi, i controller tradizionali potrebbero non essere più sufficienti. I controller più avanzati possono eseguire una programmazione più intelligente, incorporare l'accelerazione (ad esempio, compressione/decompressione, prefiltraggio sull'unità) e implementare routine FTL più complesse per ottimizzare il consolidamento della scrittura e la garbage collection, riducendo così l'amplificazione della scrittura e migliorando la resistenza.

Un altro sviluppo degno di nota è quello dello "storage computazionale", ovvero l'incorporazione di unità di elaborazione specializzate all'interno dell'unità SSD in modo che alcune operazioni di calcolo (ad esempio, l'estrazione di caratteristiche, la vettorizzazione, il pre-filtraggio) possano avvenire vicino allo storage stesso. Per l'intelligenza artificiale, ciò significa che le stesse unità SSD possono eseguire il filtraggio iniziale o la generazione di embedding, riducendo il movimento dei dati tra host e storage e migliorando l'efficienza end-to-end. Se questa capacità diventa standardizzata e il supporto del sistema software matura, potrebbe rimodellare profondamente le pipeline di IA su larga scala.

Oltre all'hardware e ai protocolli, sta cambiando anche il modo in cui lo storage viene integrato a livello di sistema. Ad esempio, CXL (Compute Express Link) offre un modo per accoppiare più strettamente memoria e storage persistente, rendendo le risorse di memoria o quasi-memoria dinamicamente accessibili tra i vari nodi, un aspetto importante per l'addestramento di grandi modelli di intelligenza artificiale con enormi volumi di parametri. Se il CXL dovesse essere adottato su larga scala, il posizionamento e le caratteristiche richieste delle unità SSD potrebbero cambiare; in alcuni casi, la memoria persistente (PMEM) o la memoria di classe storage (SCM) potrebbero diventare valide, ma a causa del costo e della maturità dell'ecosistema, si prevede che le unità SSD NVMe manterranno il predominio nel prossimo futuro.

Come i database vettoriali, l'SDS e la governance dei dati influiscono sull'utilizzo delle unità SSD

L'hardware pone le basi, ma la chiave è ancora il modo in cui il software sfrutta l'hardware per servire le pipeline di intelligenza artificiale. Negli ultimi anni, i database vettoriali, che sono il fulcro della ricerca semantica e degli scenari RAG, sono cresciuti a un ritmo vertiginoso nel 2024-2025. Questi database adottano in genere un'architettura di archiviazione a livelli "DRAM + NVMe SSD", mantenendo i vettori caldi in memoria e i set di vettori più grandi e vicini alla linea su NVMe SSD per bilanciare costi e reattività. L'aumento dei database vettoriali ha aumentato direttamente l'importanza delle unità SSD NVMe negli scenari di recupero e ha spinto i fornitori a ottimizzare le unità SSD per garantire stabilità in lettura casuale e bassa latenza.

Allo stesso tempo, i fornitori di software-defined storage (SDS) stanno offrendo servizi di storage a blocchi ad alte prestazioni in ambienti cloud e private-cloud. L'SDS si distingue perché è in grado di orchestrare le risorse SSD sottostanti per fornire QoS (qualità del servizio), scalabilità elastica e tiering dei dati caldo/freddo a grana più fine, molto utile per le piattaforme che devono gestire carichi di lavoro di formazione e di inferenza simultaneamente, controllando i costi.

Un'altra dimensione spesso trascurata è la governance dei dati e gli strumenti di versionamento. Nei flussi di lavoro dei modelli di intelligenza artificiale, numerosi checkpoint e versioni dei set di dati (ad esempio, tramite DVC o strumenti simili) generano modelli di scrittura distinti. Tra questi, le scritture periodiche di snapshot, i set di dati ramificati e i registri di controllo, che comportano picchi di carico di scrittura. Per i fornitori di SSD e gli architetti di sistema, la modellazione di queste curve di scrittura e la progettazione di strategie di caching corrispondenti diventano necessarie per garantire che il sistema possa funzionare in modo stabile a lungo termine.

Domanda e offerta e dinamiche di mercato

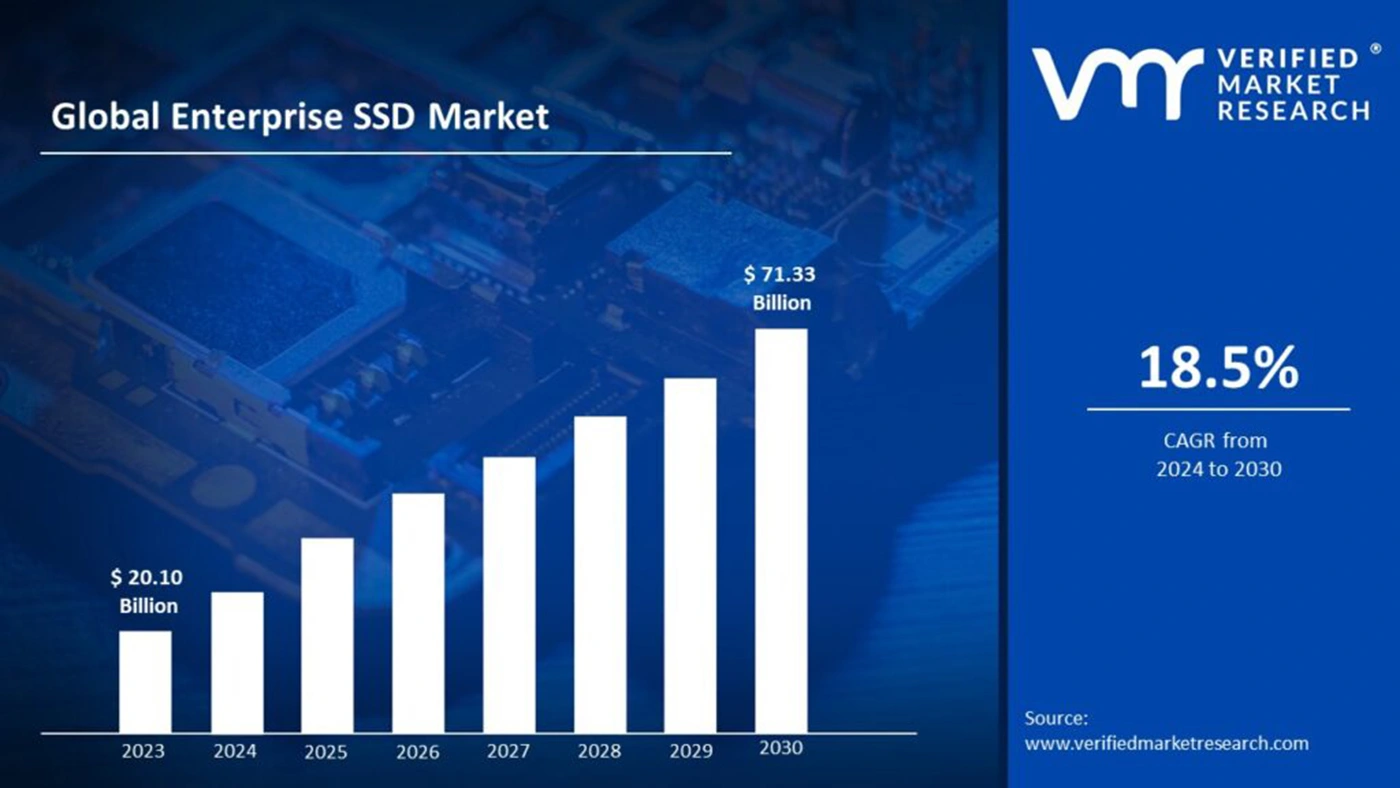

L'esplosione dell'intelligenza artificiale sta riportando sotto i riflettori le risorse di memoria e di archiviazione, ponendo sfide di bilanciamento tra domanda e offerta per le memorie NAND flash. Rapporti di settore e articoli di cronaca indicano che i fornitori di memoria nel 2025 stanno considerando la domanda di HBM e di altri tipi di memoria da parte dell'IA come una variabile chiave per la crescita dei ricavi. Sebbene la HBM sia più direttamente destinata agli acceleratori, la pressione al rialzo della domanda di memoria e NAND influenza le strutture dei costi e i tempi di consegna degli SSD.

Dal punto di vista del mercato, le previsioni sui ricavi delle unità SSD mostrano traiettorie positive e una quota crescente per le unità SSD di livello enterprise e specifiche per l'intelligenza artificiale. Ad esempio, secondo una previsione, le dimensioni del mercato delle unità SSD saranno di 55,73 miliardi di dollari nel 2025 e raggiungeranno i 266,68 miliardi di dollari entro il 2034.

Tuttavia, l'espansione della capacità è ad alta intensità di capitale e richiede tempo; qualsiasi stima errata della domanda futura può portare a un eccesso di offerta o a una carenza, entrambi causa di oscillazioni dei prezzi. Queste incertezze impongono agli operatori del settore di adottare una pianificazione più cauta. A complicare ulteriormente la situazione ci sono i rischi della catena di fornitura globale: le tensioni geopolitiche, la volatilità dei prezzi delle materie prime e il ritmo degli investimenti nelle apparecchiature possono influire sui cicli di rilascio degli SSD e sulle prestazioni di consegna. I fornitori devono bilanciare gli investimenti in R&S e l'espansione della capacità: garantire l'idoneità dei prodotti futuri per gli scenari di IA, evitando al contempo gli oneri di inventario derivanti dalla sovraccapacità.

Rischi, sfide e tre punti di osservazione chiave per il futuro

Quando si prevedono gli sviluppi futuri, è fondamentale mantenere la sensibilità alle incertezze. In primo luogo, standard come CXL e PCIe 6.0 potrebbero impiegare più tempo del previsto per raggiungere un'adozione diffusa; se il loro ecosistema matura lentamente, il previsto disaccoppiamento memoria-storage potrebbe essere ritardato. In secondo luogo, l'effettiva diffusione dello storage computazionale è ancora da vedere; molti scenari prevedono la migrazione della logica di calcolo verso le unità SSD, che richiede il supporto completo dello stack software e il coordinamento dell'ecosistema: un obiettivo che i produttori di hardware non possono raggiungere da soli. In terzo luogo, tecnologie alternative (come SCM, PMEM o altre future memorie non volatili) potrebbero raggiungere le attuali soluzioni NAND in termini di costi o prestazioni, il che cambierebbe i profili della domanda di SSD a lungo termine.

Inoltre, il consumo energetico e la sostenibilità diventeranno sempre più importanti. L'addestramento su larga scala di modelli di classe GPT e l'implementazione massiccia di unità SSD possono far aumentare in modo significativo il consumo energetico dei data center. Oltre all'efficienza dell'hardware, il settore deve investire in metriche come le prestazioni per watt e una programmazione più intelligente per soddisfare le esigenze normative e di ESG delle aziende.

Panoramica della timeline: Pietre miliari e evoluzione del settore

| Tempo (prossimi 3 anni) | Evento o tendenza chiave | Impatto specifico sul settore degli SSD |

|---|---|---|

| 2024-2025 | Rapida crescita dell'addestramento di modelli su scala ultra-grande e commercializzazione di database vettoriali | Stimola la domanda di SSD NVMe ad alta capacità e di dispositivi high-IOPS; nel breve termine accelera l'espansione del mercato delle SSD di livello enterprise. |

| 2025 | Aumento della domanda di memorie HBM e ad alta larghezza di banda; alcune capacità di memoria sono state rese prioritarie dai progetti di AI | Le limitazioni nella fornitura di memorie e chip di fascia alta possono indirettamente aumentare i costi degli SSD e ritardare le consegne. |

| 2025-2026 | Diffusione più ampia di PCIe 5.0; creazione graduale degli ecosistemi PCIe 6.0 e CXL | Aumenta la larghezza di banda massima per unità e consente un maggiore flusso di dati in parallelo; supporta architetture di archiviazione più flessibili. |

| 2026-2027 | Sperimentazione e implementazione di storage computazionale e SDS in alcuni scenari cloud o edge | Se riuscirà a ridurre in modo significativo i colli di bottiglia end-to-end, promuoverà una più profonda co-innovazione storage-software e rimodellerà il posizionamento degli SSD. |

Il ruolo dell'SSD si sta spostando da "portatore" a "partecipante attivo".

In sintesi, l'impatto dell'intelligenza artificiale sul settore delle unità SSD nel 2025 è già più che un semplice impulso all'espansione della capacità: si tratta di un cambiamento sistematico che tocca le metriche delle prestazioni, l'innovazione di controller/firmware, la collaborazione tra software ed ecosistema e il riallineamento della catena di fornitura. Le unità SSD si stanno trasformando da prodotti hardware relativamente passivi in componenti chiave che partecipano attivamente alle pipeline di elaborazione dei dati.

L'ascesa dell'intelligenza artificiale non porta solo mercati più ampi e maggiori opportunità di guadagno, ma anche una profonda introspezione nella filosofia di progettazione delle unità SSD e nei modelli di collaborazione del settore. Nei prossimi tre-cinque anni, coloro che riusciranno a realizzare innovazioni rivoluzionarie nei controller, nel firmware e nello storage software-defined probabilmente conquisteranno la leadership strutturale in un mercato dello storage guidato dall'intelligenza artificiale. In un ambiente tecnologico e di mercato in rapida evoluzione, la combinazione di una strategia prudente ma proattiva, di una cooperazione tra i vari sistemi e di investimenti in tendenze tecniche a lungo termine sarà la chiave del successo.