En 2025, la inteligencia artificial (IA) ha superado las primeras fases de experimentación y despliegue inicial, entrando en una fase de amplia aplicación e implantación industrial a gran escala. Tanto si se trata de la formación de modelos a gran escala como de la inferencia de baja latencia en aplicaciones empresariales, los escenarios de uso de la IA y los volúmenes de datos están creciendo de forma explosiva. Esta ola de crecimiento no sólo está transformando la estructura de los recursos informáticos, sino que también está remodelando profundamente el perfil de demanda de la capa de almacenamiento, especialmente unidades de estado sólido (SSD). Como componente clave para la lectura y persistencia de datos, las SSD ya no son meros módulos pasivos de "capacidad"; se están convirtiendo en elementos críticos de rendimiento e inteligencia a nivel de sistema.

Antecedentes: Cómo la escalabilidad de la IA impulsa la demanda de almacenamiento

En los últimos años, el tamaño de los modelos de IA y el cálculo necesario para su entrenamiento han crecido a ritmos asombrosos. Según Informe sobre el Índice de Inteligencia Artificial 2025 de Stanford HAI, el cálculo de entrenamiento de modelos de IA notables se ha duplicado en periodos de tiempo cada vez más cortos, y el tamaño de los conjuntos de datos también está aumentando rápidamente, lo que significa que el entrenamiento de un gran modelo de IA requiere ahora exponencialmente más recursos de almacenamiento, ancho de banda y persistencia. Y lo que es más importante, estos modelos a gran escala han pasado de los entornos de desarrollo a la implantación en amplias empresas y a escenarios de inferencia en línea, lo que impulsa la demanda real de sistemas de almacenamiento de baja latencia y alta concurrencia.

Para ponerlo en perspectiva: la formación en la nube requiere datos sin procesar a nivel de petabytes y cientos de terabytes a petabytes de pesos de modelos, mientras que los escenarios de inferencia y generación de recuperación aumentada (RAG) introducen miles de pequeñas solicitudes de E/S aleatorias y lecturas concurrentes elevadas. Estas tendencias suponen un reto para las unidades SSD que no puede abordarse simplemente aumentando su capacidad.

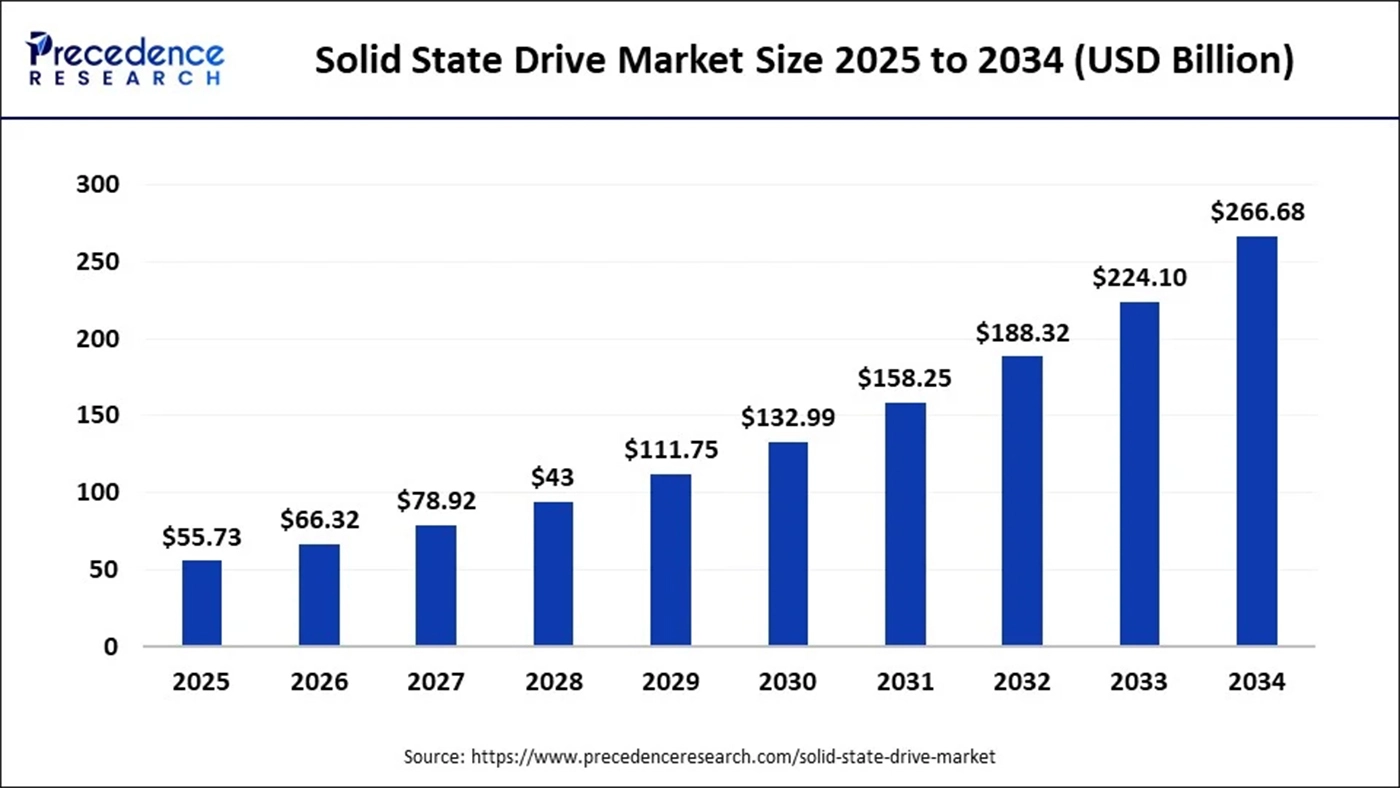

Mientras tanto, las previsiones de las empresas de investigación de mercado para el mercado de SSD reflejan la IA como un importante motor de crecimiento. Por ejemplo, una de las previsiones indica que el tamaño del mercado mundial de SSD en 2025 será de aproximadamente 1.000 millones de euros. 55.730 millones de dólaresy las previsiones se elevan a unos 266.680 millones de dólares en 2034.

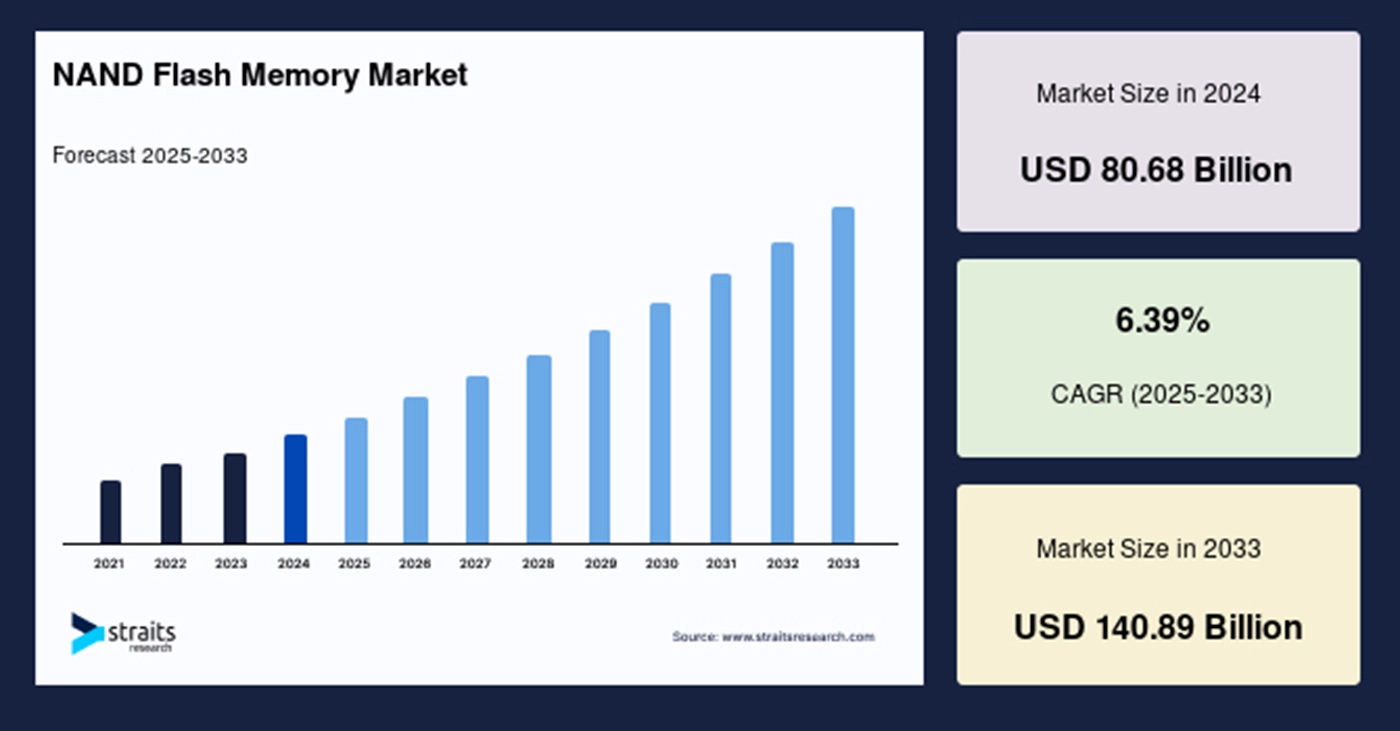

Este crecimiento subraya que la IA está aumentando tanto la demanda de unidades SSD de gama alta como la demanda de bits de Flash NAND en general, lo que afecta a la planificación de la capacidad de la cadena de suministro y a la fijación de precios.

Por el lado de la oferta, los proveedores de memorias son cada vez más conscientes de la demanda estructural de IA de memoria de gran ancho de banda (HBM), DRAM y NAND. Por ejemplo, un importante proveedor de memorias en 2025 declaró que la demanda de IA de HBM y otros tipos de memoria es una variable de crecimiento clave, lo que indica que las cadenas de suministro de memoria y NAND se están viendo afectadas por proyectos de IA que pueden tener prioridad.

Además, el ecosistema de almacenamiento en torno a la IA está formando nuevas arquitecturas de datos y capas de servicios. Las bases de datos vectoriales como infraestructura central para la recuperación y la búsqueda semántica han crecido rápidamente en 2024-2025, y su dependencia del almacenamiento near-line (a menudo SSD NVMe) subraya la creciente importancia de las SSD en la pila de IA. En conjunto, la ampliación de la IA no solo está aumentando la demanda de "capacidad", sino también los requisitos de rendimiento (rendimiento, IOPS, latencia), resistencia (durabilidad de escritura) e inteligencia (firmware y almacenamiento habilitado para computación).

Cómo las cargas de trabajo de IA redefinen las métricas técnicas de las SSD

Tradicionalmente, la selección de unidades SSD ha consistido en un equilibrio entre capacidad, coste por GB y rendimiento de lectura/escritura secuencial. Pero las cargas de trabajo de IA plantean nuevas exigencias que hacen que esta tríada sea insuficiente.

En la fase de formación, la demanda de almacenamiento hace hincapié en la gran capacidad y el alto rendimiento secuencial, pero al mismo tiempo requiere un ancho de banda paralelo muy alto y capacidad de escritura persistente. Los flujos de trabajo de formación implican frecuentes escrituras de puntos de control, el almacenamiento distribuido de fragmentos de modelos y el preprocesamiento masivo de datos de muestra.

En los escenarios de inferencia en línea y RAG, las unidades SSD se enfrentan a un conjunto diferente de exigencias. Estos escenarios suelen implicar muchas pequeñas lecturas aleatorias con una latencia muy baja, especialmente cuando los índices vectoriales o las incrustaciones se fragmentan y la recuperación genera miles de pequeñas solicitudes de E/S aleatorias simultáneas. La baja latencia y las altas IOPS se convierten así en factores críticos para la respuesta del sistema y la experiencia del usuario. En muchas implantaciones reales, la memoria caché DRAM por sí sola no puede cubrir el conjunto de trabajo, lo que hace que Unidades SSD NVMe el nivel necesario para el almacenamiento near-line; por lo tanto, la SSD debe mantener un alto rendimiento de lectura aleatoria al tiempo que equilibra el coste y la capacidad.

Además, en el contexto del ciclo de vida de la IA, prácticas como los puntos de control incrementales, el ajuste fino de los modelos y la sincronización parámetro-servidor aumentan la frecuencia de las escrituras y exacerban la amplificación de las mismas. Así pues, las métricas de resistencia (por ejemplo, TBW, DWPD) de las SSD son más importantes que el simple rendimiento bruto. Los fabricantes de SSD deben adoptar algoritmos avanzados de capa de conversión flash (FTL), estrategias más inteligentes de recogida de basura y mecanismos de consolidación de escritura más eficientes para prolongar la vida útil y mantener el rendimiento.

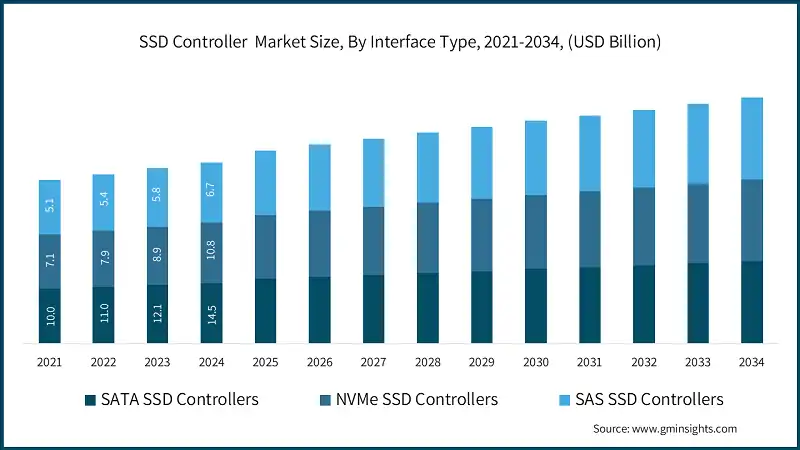

Desde el punto de vista de la arquitectura general del sistema, las tecnologías de interconexión (por ejemplo, PCIe 5.0/6.0, CXL) y los protocolos de almacenamiento distribuido (como NVMe-oF) se están convirtiendo en la columna vertebral que une las SSD y los nodos de cálculo. Su mayor ancho de banda y menor sobrecarga de comunicación hacen más eficiente el acceso al almacenamiento en la formación a gran escala, lo que a su vez impulsa el papel de las SSD en la arquitectura: ya no son un mero almacén estático de datos, sino un canal de datos en tiempo real estrechamente acoplado a la computación.

Hojas de ruta tecnológicas: Cómo responden las SSD a las nuevas necesidades de la IA

En respuesta a la evolución de la demanda, los fabricantes de SSD y los arquitectos de sistemas están siguiendo unas directrices de diseño claras. En primer lugar, las actualizaciones de interfaces y protocolos son fundamentales. PCIe 5.0 ya se está adoptando, y PCIe 6.0 en los próximos años. Un mayor ancho de banda de enlace amplía directamente el rendimiento máximo disponible por unidad y reduce la dependencia de muchas unidades paralelas, lo que aumenta la flexibilidad de integración del sistema.

En cuanto a la elección de la matriz NAND, los proveedores deben sopesar el coste frente al rendimiento. QLC y las próximas NAND de celdas multibit, gracias a su menor coste y mayor densidad de bits, son muy adecuadas para el almacenamiento de datos en frío o "caliente", ya que permiten la retención económica de datos a gran escala. Al mismo tiempo, los tipos SLC/MLC -o las matrices de gama alta para empresas- siguen siendo esenciales para los datos calientes que requieren altas IOPS y una larga vida útil. Por ello, muchos fabricantes añaden zonas de caché DRAM o SLC más grandes a las unidades SSD y aplican un escalonamiento frío/caliente inteligente para que las QLC sigan ofreciendo un rendimiento aceptable en situaciones con muchas escrituras aleatorias.

La innovación en controladores y firmware es aún más crítica. Dado que los escenarios de IA imponen patrones de E/S más complejos, es posible que los controladores tradicionales ya no sean suficientes. Los controladores más avanzados pueden realizar una programación más inteligente, incorporar aceleración (por ejemplo, compresión/descompresión, prefiltrado en la unidad) e implementar rutinas FTL más complejas para optimizar la consolidación de escritura y la recogida de basura, reduciendo así la amplificación de escritura y mejorando la resistencia.

Otro avance digno de mención es el "almacenamiento computacional", es decir, la incorporación de unidades de procesamiento especializadas dentro de la SSD para que parte de la computación (por ejemplo, la extracción de características, la vectorización o el filtrado previo) pueda realizarse cerca del propio almacenamiento. Para la IA, esto significa que las propias SSD pueden realizar el filtrado inicial o la generación de incrustaciones, reduciendo el movimiento de datos entre el host y el almacenamiento y mejorando la eficiencia de extremo a extremo. Si esta capacidad se estandariza y madura el soporte del ecosistema de software, podría remodelar profundamente los procesos de IA a gran escala.

Más allá del hardware y los protocolos, también está cambiando la forma de integrar el almacenamiento en el sistema. Por ejemplo, CXL (Compute Express Link) ofrece una forma de vincular más estrechamente la memoria y el almacenamiento persistente, haciendo que los recursos de memoria o casi memoria sean accesibles dinámicamente en todos los nodos, lo que es importante cuando se entrenan grandes modelos de IA con enormes volúmenes de parámetros. En algunos casos, la memoria persistente (PMEM) o la memoria de clase de almacenamiento (SCM) podrían ser viables, pero debido al coste y a la madurez del ecosistema, se espera que las SSD NVMe mantengan el dominio en el futuro inmediato.

Cómo afectan las bases de datos vectoriales, el SDS y la gobernanza de datos al uso de las SSD

El hardware sienta las bases, pero la clave sigue siendo cómo el software aprovecha ese hardware para servir a los conductos de IA. En los últimos años, las bases de datos vectoriales, como núcleo de la búsqueda semántica y los escenarios RAG, han crecido a un ritmo vertiginoso en 2024-2025. Estas bases de datos suelen adoptar una arquitectura de almacenamiento por niveles "DRAM + SSD NVMe", manteniendo los vectores calientes en memoria y los conjuntos de vectores más grandes y cercanos a la línea en SSD NVMe para equilibrar el coste y la capacidad de respuesta. El auge de las bases de datos vectoriales ha aumentado directamente la importancia de las SSD NVMe en los escenarios de recuperación y ha empujado a los proveedores a optimizar las SSD para conseguir estabilidad de lectura aleatoria y baja latencia.

Al mismo tiempo, los proveedores de almacenamiento definido por software (SDS) ofrecen servicios de almacenamiento en bloque de alto rendimiento en entornos de nube y nube privada. El SDS brilla porque puede orquestar los recursos SSD subyacentes para proporcionar QoS (calidad de servicio), escalado elástico y clasificación de datos en caliente y en frío de grano fino, lo que resulta muy útil para plataformas que necesitan gestionar cargas de trabajo de formación e inferencia al mismo tiempo que controlan los costes.

Otra dimensión que a menudo se pasa por alto es la gobernanza de datos y las herramientas de versionado. En los flujos de trabajo de modelos de IA, numerosos puntos de control y versiones de conjuntos de datos (por ejemplo, a través de DVC o herramientas similares) generan distintos patrones de escritura. Entre ellos se incluyen las escrituras periódicas de instantáneas, los conjuntos de datos ramificados y los registros de auditoría, todo lo cual genera picos en las cargas de escritura. Para los proveedores de SSD y los arquitectos de sistemas, modelar estas curvas de escritura y diseñar las estrategias de almacenamiento en caché correspondientes se hace necesario para garantizar que el sistema pueda funcionar de forma estable a largo plazo.

Oferta y demanda y dinámica del mercado

La explosión de la IA está volviendo a poner de actualidad los recursos de memoria y almacenamiento, lo que plantea retos de equilibrio entre la oferta y la demanda para la memoria flash NAND. Los informes del sector y los artículos de prensa indican que los proveedores de memoria en 2025 están considerando la demanda de HBM y otros tipos de memoria para la IA como una variable clave para el crecimiento de los ingresos. Aunque la HBM se dirige más directamente a los aceleradores, la presión al alza de la demanda de memoria y NAND influye en las estructuras de costes y los plazos de entrega de las SSD.

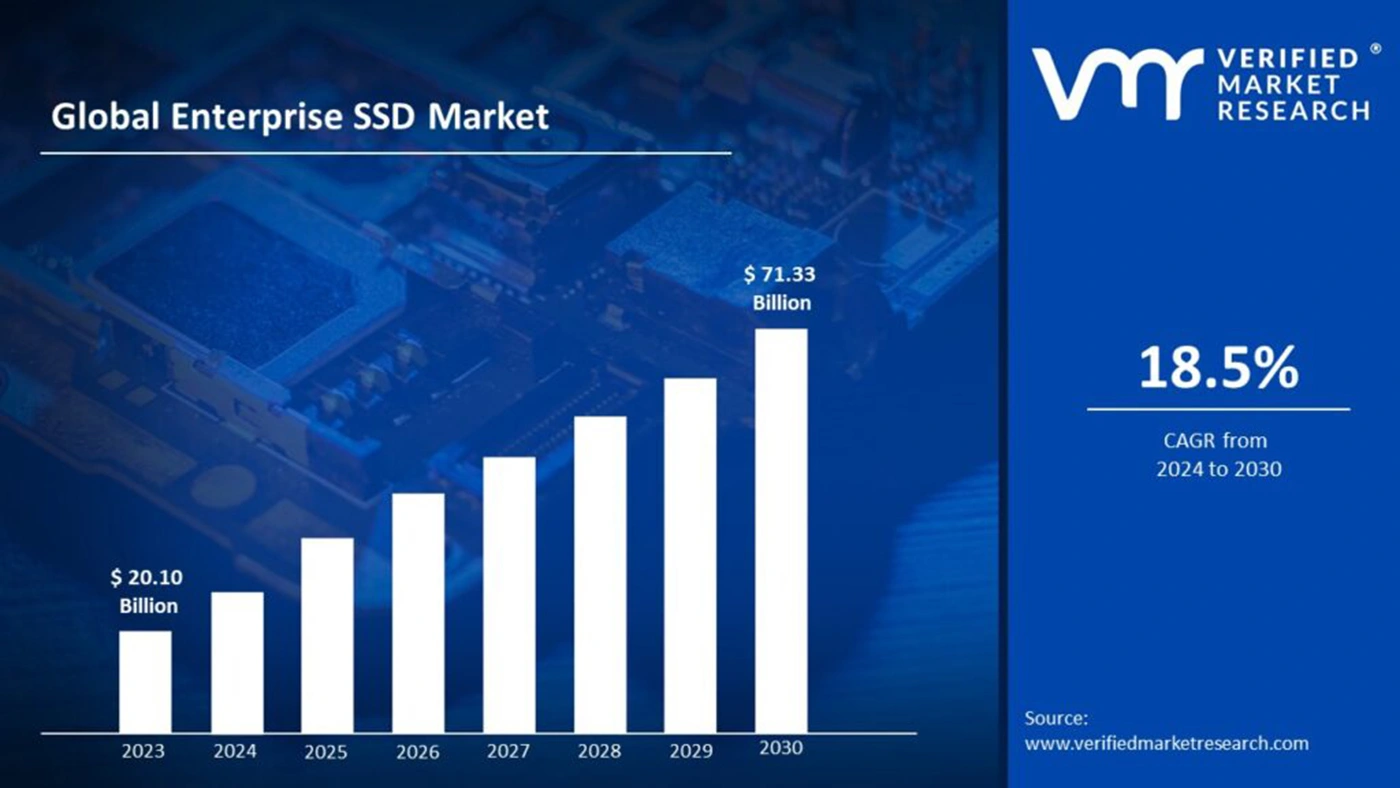

Desde el punto de vista del mercado, las previsiones de ingresos de las SSD muestran trayectorias positivas y una cuota cada vez mayor para las SSD de nivel empresarial y específicas para IA. Por ejemplo, una previsión sitúa el tamaño del mercado de las SSD en 55 730 millones de dólares en 2025 y alcanzará los 266 680 millones de dólares en 2034.

Sin embargo, la expansión de la capacidad requiere mucho capital y tiempo; cualquier estimación errónea de la demanda futura puede provocar un exceso de oferta o escasez, dos factores que causan oscilaciones de precios. Estas incertidumbres obligan a los agentes del sector a adoptar una planificación más prudente. Para complicar aún más la situación, están los riesgos de la cadena de suministro mundial: las tensiones geopolíticas, la volatilidad de los precios de las materias primas y el ritmo de inversión en equipos pueden afectar a los ciclos de lanzamiento de las SSD y al rendimiento de las entregas. Los proveedores deben equilibrar la inversión en I+D y la expansión de la capacidad: garantizar la idoneidad futura de los productos para los escenarios de IA y, al mismo tiempo, evitar las cargas de inventario derivadas del exceso de capacidad.

Riesgos, retos y tres puntos de referencia para el futuro

A la hora de prever la evolución futura, es fundamental mantener la sensibilidad ante las incertidumbres. En primer lugar, es posible que estándares como CXL y PCIe 6.0 tarden más de lo esperado en lograr una adopción generalizada; si su ecosistema madura lentamente, la disociación prevista entre memoria y almacenamiento puede retrasarse. En segundo lugar, aún está por ver la escala real de implantación del almacenamiento computacional; muchos escenarios implican la migración de la lógica computacional a las SSD, lo que exige un soporte completo de la pila de software y la coordinación del ecosistema, algo que los proveedores de hardware no pueden conseguir por sí solos. En tercer lugar, las tecnologías alternativas (como SCM, PMEM u otras futuras memorias no volátiles) pueden alcanzar en coste o rendimiento a las actuales soluciones NAND, lo que cambiaría los perfiles de demanda de SSD a largo plazo.

Además, el consumo de energía y la sostenibilidad serán cada vez más importantes. La formación a gran escala de modelos de clase GPT y los despliegues masivos de unidades SSD pueden aumentar considerablemente el consumo energético de los centros de datos. Más allá de la eficiencia del hardware, el sector debe invertir en métricas como el rendimiento por vatio y una programación más inteligente para satisfacer las exigencias normativas y de ESG de las empresas.

Cronología: Principales hitos y evolución del sector

| Tiempo (próximos 3 años) | Evento o tendencia clave | Impacto específico en la industria de las SSD |

|---|---|---|

| 2024-2025 | Rápido crecimiento de la formación de modelos a escala ultra grande y comercialización de bases de datos vectoriales | Impulsa la demanda de SSD NVMe de alta capacidad y dispositivos de alto IOPS; a corto plazo acelera la expansión del mercado de SSD de nivel empresarial. |

| 2025 | Aumento de la demanda de HBM y memoria de gran ancho de banda; los proyectos de IA dan prioridad a cierta capacidad de memoria | Las limitaciones en el suministro de memorias y chips de gama alta pueden elevar indirectamente los costes de las SSD y retrasar las entregas. |

| 2025-2026 | Mayor despliegue de PCIe 5.0; establecimiento gradual de los ecosistemas PCIe 6.0 y CXL | Aumenta el ancho de banda máximo por unidad y permite un mayor flujo de datos en paralelo; admite arquitecturas de almacenamiento más flexibles. |

| 2026-2027 | Prueba y despliegue de almacenamiento computacional y SDS en algunos escenarios de nube o de borde | Si consigue una reducción significativa de los cuellos de botella de extremo a extremo, promoverá una mayor co-innovación entre almacenamiento y software y reconfigurará el posicionamiento de las SSD. |

El papel del SSD está pasando de "portador" a "participante activo"

En resumen, el impacto de la IA en el sector de las SSD en 2025 ya va más allá del simple aumento de la capacidad: se trata de un cambio sistemático que afecta a las métricas de rendimiento, la innovación en controladores y firmware, la colaboración entre el ecosistema de software y la realineación de la cadena de suministro. Las SSD están pasando de ser productos de hardware relativamente pasivos a componentes clave que participan activamente en los canales de procesamiento de datos.

El auge de la IA no solo trae consigo mercados más grandes y mayores oportunidades de ingresos, sino también una profunda introspección en la filosofía de diseño de las SSD y los modelos de colaboración del sector. En los próximos tres a cinco años, quienes logren una innovación revolucionaria en controladores, firmware y almacenamiento definido por software probablemente se harán con el liderazgo estructural en un mercado de almacenamiento impulsado por la IA. En un entorno tecnológico y de mercado en rápida evolución, la combinación de una estrategia prudente pero proactiva, la cooperación entre ecosistemas y la inversión en tendencias técnicas a largo plazo será la clave del éxito.