随着 DDR5 内存刚刚完成在消费市场的初步渗透,并继续稳步提高其在服务器领域的采用率,有关 DDR6 的讨论在业内外悄然升温。这并非技术领域的 "过早炒作",而是市场需求和技术演进的必然结果。当前,生成式人工智能、高性能计算、云计算等领域正在经历爆发式增长,对内存带宽、容量和能效提出了前所未有的严格要求。根据TrendForce的预测,从2024年到2026年,人工智能和服务器相关应用对DRAM总容量的需求将分别达到46%、56%和66%,预计2027年这一数字将超过70%。即使是目前最强大的 DDR5 内存也逐渐无法满足人工智能训练和大规模数据处理场景的海量数据吞吐量要求。

与此同时,在消费市场,高端游戏笔记本电脑和移动工作站不断追求更高的内存频率和更大的容量,而轻薄型设备则对内存功耗和物理空间提出了严格限制。所有这些因素都在加速新一代内存标准的制定。三星、SK hynix 和美光等全球主要内存制造商已经完成了 DDR6 规格的早期原型开发,并正在与英特尔、AMD 和 NVIDIA 等芯片供应商合作推进平台验证。

DDR 内存的发展历程

什么是 DDR 内存?为什么 "带宽 "如此重要?

DDR 内存是双倍数据速率同步动态随机存取内存的简称,是计算机系统中负责临时存储数据的核心部件。它还是 CPU 与硬盘等存储设备之间的数据传输桥梁。其核心工作原理基于同步时钟信号,允许在每个时钟周期的上升沿和下降沿传输数据。因此,在相同的时钟频率下,数据传输效率提高了一倍,这就是 "双倍数据速率 "一词的由来。

在 DDR 内存的所有性能指标中,带宽无疑是最关键的指标。内存带宽是指内存在单位时间内可传输的数据量。计算公式为:带宽 = 内存频率 × 总线宽度 × 通道数 ÷ 8。带宽直接决定了 CPU 访问数据的速度。可以把它比作数据传输的 "高速公路":高速公路越宽,数据传输效率越高。在运行大型 AAA 游戏、执行视频编辑和渲染或训练人工智能模型等复杂应用场景中,CPU 需要持续高速读写大量数据。如果内存带宽不足,就会出现 "数据拥塞",导致 CPU 长时间等待数据。在这种情况下,即使是非常强大的 CPU 也无法完全发挥性能,从而造成系统性能瓶颈。因此,提高内存带宽一直是每一代 DDR 内存技术发展的核心目标之一。

从 DDR1 到 DDR5:每一代都解决了哪些问题

从 DDR1 到 DDR5,每一代内存的设计都是为了直接应对当时业界面临的主要挑战,通过技术创新实现性能的显著提升。DDR1 是第一代 DDR 内存,出现于 2000 年前后。它的核心突破是实现了双倍数据速率传输,取代了传统的 SDRAM,初步解决了早期计算机系统内存传输速度不足的问题。它为奔腾 4 等早期处理器提供了兼容内存支持,数据传输速率从 200 MT/s 到 400 MT/s。

DDR2 内存于 2004 年左右推出,主要解决了 DDR1 的局限性,包括最高速度低和功耗相对较高。通过改进内存芯片制造工艺和信号处理技术,DDR2 将数据传输速率提高到 533-800 MT/s,同时将工作电压从 DDR1 的 2.5 V 降至 1.8 V,从而大大降低了功耗和发热量,更适合当时多核处理器的发展。

2007 年出现的 DDR3 内存进一步突破了速度限制,将最大数据传输速率提高到 1600 MT/s,并将工作电压降低到 1.5 V,从而大大提高了能效。更重要的是,DDR3 通过优化内存控制器设计,提高了内存的稳定性和兼容性。它支持笔记本电脑、台式机和服务器的广泛采用,成为寿命最长的内存标准之一。

DDR4 内存于 2014 年推出,旨在满足大数据时代对内存容量和带宽的双重需求。它将数据传输速率提高到 2133-3200 MT/s,将工作电压降低到 1.2 V,同时还支持更大的单模块容量,每个模块最大可达 128 GB。通过引入 Bank Group 技术,DDR4 提高了并发内存访问能力,有效降低了多任务处理场景下的带宽压力,成为过去十年计算机系统的主流内存配置。

2021 年底正式商用的 DDR5 内存在速度和能效方面实现了又一次重大飞跃,满足了早期人工智能和高性能计算的需求。其最大数据传输速率高达 8000 MT/s,工作电压进一步降至 1.1 V,并采用 2 × 32 位通道结构,增强了并行处理能力。DDR5 还首次在消费类内存中引入了片上 ECC 纠错功能,提高了数据传输的稳定性,单模块容量最高可达 256 GB。然而,随着人工智能应用的持续爆发式增长,DDR5 的性能极限逐渐显现,为 DDR6 的发展奠定了基础。

什么是 DDR6

DDR6 是由 JEDEC(电子器件工程联合委员会)主导的下一代双数据速率同步动态随机存取存储器标准。它旨在满足人工智能、高性能计算和云计算等新兴领域对内存带宽、容量和能效的极高要求。DDR6 标准化进程于 2024 年正式启动,其核心目标是突破 DDR5 的物理性能限制,创建一个具有高带宽、大容量、高能效和高可靠性的内存平台。

到 2024 年底,JEDEC 完成了 DDR6 的主要规范草案,为后续技术开发和产品实施奠定了基础。与此同时,低功耗版本 LPDDR6 的规范草案也于 2025 年第二季度发布。与以往的内存标准制定过程类似,DDR6 的制定汇集了全球主要内存制造商、芯片设计商和终端设备供应商。这确保了该标准能够支持不同的应用场景和硬件平台,同时促进了整个行业生态系统的协调发展。

DDR6 旨在解决的三大核心问题

DDR6 的开发重点是应对业界目前面临的三大核心挑战: 带宽不足、能效低和架构限制.

第一个问题是带宽不足。 随着人工智能培训和大规模数据处理需求的快速增长,目前最高速度为 8000 MT/s 的 DDR5 越来越无法满足海量数据高速传输的要求,成为制约系统整体性能的关键瓶颈。DDR6 改进了通道架构和传输技术,将初始数据传输速率提升至 8800 MT/s,并计划在后期提升至 17600 MT/s,旨在从根本上消除高负载场景下的带宽瓶颈。

第二个问题是能效。 在人工智能服务器和数据中心环境中,内存模块的部署密度越来越高,这大大增加了功耗和发热量。这不仅提高了运营成本,也对冷却系统提出了更高的要求。通过降低工作电压和优化电源管理机制,DDR6 在提高性能的同时降低了功耗。与 DDR5 相比,典型功耗预计将降低 15-20%,从而使 DDR6 更适合高密度部署方案。

第三个问题是建筑限制。 DDR5 使用的 2 × 32 位通道结构在高频率下容易出现信号完整性问题。此外,传统的 DIMM 和 SO-DIMM 外形在 2DPC 配置下存在空间要求大和频率限制的问题。DDR6 引入了创新的 4 × 24 位子通道架构,并采用了 CAMM2 接口标准。这不仅提高了并行处理能力,还解决了传统内存封装在空间和频率方面的限制,为高性能和高密度内存部署提供了架构支持。

DDR6 的主要技术变化

数据传输速度的重大飞跃

大幅提高数据传输速度是 DDR6 最重要的技术突破之一。根据目前的行业路线图,DDR6 的初始数据传输速率将达到 8800 MT/s,已经超过了目前 DDR5 8000 MT/s 的最高传输速率。在整个产品生命周期内,DDR6 的速度预计将进一步提高到 17600 MT/s,某些超频版本可能会超过 21000 MT/s。整体性能预计将比 DDR5 高出约两到三倍。

如此大幅度的速度提升并不是仅仅通过提高时钟频率就能实现的。相反,它是多种技术共同作用的结果。一方面,DDR6 优化了内存芯片制造工艺,提高了电气性能,为高频运行奠定了硬件基础。另一方面,DDR6 引入了更先进的信号完整性优化设计,包括改进的封装技术、更精细的布线规则和更严格的时序控制。这些措施有效降低了高频率下的信号干扰和衰减。此外,与 DDR5 采用的 8n 预取机制相比,DDR6 采用了 16n 预取机制。这进一步提高了数据传输效率,允许在相同的时钟频率下传输更多的数据,使整体传输速度实现了重大飞跃。

子通道结构的变化

DDR6 采用 4 × 24 位子通道结构,取代了 DDR5 使用的 2 × 32 位通道设计,在通道架构方面进行了颠覆性创新。这一架构变革的核心目标是提高带宽,同时在高工作频率下保持信号完整性。传统的宽总线设计往往会在频率增加到一定程度后出现信号串扰,导致传输稳定性降低。通过增加通道数和减少每个通道的位宽,DDR6 将总线宽度从 DDR5 的 64 位扩大到 96 位。这种方法增强了并行处理能力,同时降低了每个通道的信号传输压力。

4 × 24 位子通道架构实现了更高效的并行数据传输,允许每个子通道独立执行读写操作。这大大提高了内存并发性和带宽利用率。在人工智能训练和大规模数据处理等必须同时处理多个数据流的场景中,这种架构的优势尤为明显。同时,子通道架构为容量扩展和能效优化提供了更大的灵活性。它允许根据应用要求动态调整每个子通道的工作状态,从而在性能和功耗之间实现更好的平衡。

模块和接口外形尺寸的变化 (CAMM2)

DDR6 将全面采用 CAMM2 接口标准,取代使用多年的传统 DIMM 和 SO-DIMM 接口。这标志着内存模块外形尺寸的重大变革。CAMM2 是压缩附加内存模块(Compression Attached Memory Module)的缩写。它最初由戴尔公司推出,后经 JEDEC 修订,并于 2023 年底正式成为 JEDEC 标准。与传统内存模块通过底部边缘连接器与插槽连接不同,CAMM2 使用压缩连接器,通过主板上的薄转接板连接,并用螺丝固定。这种新的接口形式具有几个显著的优点:

CAMM2 有效解决了传统 2DPC 配置中的频率限制问题。在传统的 2DPC 设计中,每个通道安装两个内存模块会增加电气复杂性并限制内存频率。CAMM2 将复杂的拓扑结构移至模块本身,在内部处理复杂性,使系统同时实现最高性能和最大容量。

CAMM2 大大降低了 Z 轴高度和主板整体空间占用。与 SO-DIMM 相比,CAMM2 的厚度减少了 57%,因此更适用于对厚度有严格要求的设备,如轻薄型笔记本电脑和平板电脑。

CAMM2 连接器采用 LGA 引脚设计,主板和内存模块上都有接触垫。这降低了接口损坏的风险,而且连接器本身可以独立更换,使维护更加方便。

能源效率和电源管理的进一步发展

在能效优化方面,DDR6 在 DDR5 的低功耗优势基础上实现了进一步突破。DDR5 的标准工作电压为 1.1 V,而 DDR6 将把工作电压降至 1.0 V 甚至更低。电压降低直接导致功耗降低,预计 DDR6 的典型功耗将比 DDR5 降低 15-20%。这一改进对于数据中心和人工智能服务器等高密度部署场景尤为重要,因为它有助于降低总体能耗和冷却成本,同时提高系统能效。

除了降低工作电压,DDR6 还引入了更先进的电源管理机制。通过优化内存控制器的电源管理逻辑,DDR6 可以根据系统负载动态调整内存模块的工作状态。在低负载条件下,内存频率和电压会自动降低,使系统进入低功耗模式。在高负载条件下,性能会迅速提高,以确保满足数据传输要求。这种动态电源管理方法使 DDR6 能够在不同的应用场景中实现性能和功耗之间的最佳平衡,在提供高性能的同时有效节约能源。

扩容和叠加潜力

DDR6 提供了更大的容量扩展潜力,使其更适合满足人工智能和高性能计算工作负载对大容量内存的要求。堆叠技术的创新是推动 DDR6 容量扩展的关键因素。DDR6 将采用更先进的 3D 堆叠封装技术,垂直堆叠更多的内存芯片,从而大幅提高单位芯片的容量密度。同时,CAMM2 接口的模块化设计通过支持堆叠模块配置来提高系统内存的总容量,从而为容量扩展提供了便利。

例如,两个单通道 D 型 CAMM2 模块理论上可以沿 Z 轴堆叠,使系统内存总量达到 512 GB。随着技术的成熟,可能会实现更大的容量突破。目前计划中的 DDR5 CAMM2 模块最大容量可达 256 GB。凭借更高密度的内存芯片和堆叠技术,DDR6 CAMM2 模块有望突破这一限制。

DDR6 和 DDR5 的全面比较

| 类别 | DDR5 | DDR6 |

|---|---|---|

| 数据速率 | 最高约 8000 MT/s | 初始速度为 8800 MT/s,计划提高到 17,600 MT/s,超频版可能超过 21,000 MT/s |

| 渠道架构 | 2 × 32 位(总线宽度 64 位) | 4 × 24 位(总线宽度 96 位) |

| 接口外形 | 主要是 DIMM、SO-DIMM | 完全采用 CAMM2 / LPCAMM2 |

| 工作电压 | 1.1 V | 1.0 V 或更低 |

| 典型功耗 | 基线水平 | 15-20% 低于 DDR5 |

| 每个模块的最大容量 | 256GB (DIMM),128GB (SO-DIMM) | 预计将超过 256 GB,双模块堆叠可能达到 512 GB |

| 预取机制 | 8n 预取 | 16n 预取 |

| 2DPC 频率限制 | 重要的频率限制 | 模块内部处理复杂性,无明显频率限制 |

| 主要应用场景 | 中高端个人电脑、服务器、工作站(过渡期) | 人工智能服务器、高性能计算、高端工作站、旗舰 PC |

DDR6 的兼容性

DDR6 和 DDR5 之间不存在向后兼容性。这意味着为 DDR5 设计的主板不能直接使用 DDR6 内存,反之亦然。其核心原因在于架构、接口形式因素和电气规格的根本差异。

首先是接口形式的不同。DDR6 完全采用 CAMM2 接口,而 DDR5 主要采用传统的 DIMM 和 SO-DIMM 接口。它们的物理尺寸和连接方式完全不同,互不兼容。

第二,电气规格不同。DDR6 将工作电压降至 1.0 V 甚至更低,而 DDR5 为 1.1 V。此外,它们的信号定义和时序参数也完全不同。内存控制器的设计必须考虑特定的电气规格,以便正确驱动电路和处理信号。DDR5 内存控制器无法满足 DDR6 的电气要求,强行使用会导致设备损坏或无法正常运行。

最后,通道架构也存在差异。DDR6 使用 4 × 24 位子通道架构,与 DDR5 使用的 2 × 32 位架构有本质区别。两种情况下内存控制器的设计逻辑完全不同,这最终决定了这两种标准是不兼容的。因此,DDR6 的部署需要 CPU、主板和整个行业生态系统的协调支持,以形成完整的硬件支持系统。目前,三星、SK hynix、美光等内存制造商正与英特尔、AMD、英伟达等芯片厂商密切合作,共同推进 DDR6 平台验证,加速生态系统发展。

DDR6 的应用场景分析

数据中心和云计算

数据中心和云计算是 DDR6 最重要的应用场景之一。目前,云计算服务正朝着大规模、高并发和低延迟的方向发展。数据中心必须处理大量的用户请求和数据传输任务,对内存带宽和容量提出了极高的要求。DDR6 可显著提高数据中心服务器的内存带宽,加快数据处理和传输速度,同时减少用户请求的响应延迟。

同时,DDR6 的高能效非常适合数据中心的要求。数据中心的服务器密度很高,内存模块占系统总功耗的很大一部分。与 DDR5 相比,DDR6 功耗降低了 15-20%,可有效降低数据中心的总体能耗和冷却成本,同时提高运行效率。此外,DDR6 支持大容量扩展,可满足云计算环境中大规模数据缓存和并行处理的需求。这为云数据库、云存储和云渲染等服务提供了更强大的内存支持。随着 DDR6 的商业应用,数据中心的计算和数据处理能力有望实现质的飞跃。

人工智能与高性能计算(HPC)

人工智能和高性能计算是开发和采用 DDR6 的核心驱动力,也是 DDR6 能够带来最大优势的应用场景。在人工智能训练场景中,模型参数规模不断扩大,需要处理海量训练数据。这对内存带宽和容量提出了极高的要求。DDR6 的高带宽特性可确保 CPU 和 GPU 在训练过程中快速读写训练数据,避免数据传输瓶颈,显著提高训练效率。

在高性能计算领域,如天气预报、天体物理学模拟和制药研究,系统必须执行大量复杂的计算和数据处理。这些工作负载对内存的并行处理能力和稳定性要求极高。DDR6 的 4 × 24 位子通道架构增强了并行数据处理能力,而 16n 预取机制和先进的纠错机制则确保了数据传输的效率和稳定性。此外,DDR6 的低功耗优势还有助于降低高性能计算集群的能耗,提高其长时间连续运行的能力。随着人工智能和高性能计算的不断发展,DDR6 将成为这些领域的核心内存配置。

消费类个人电脑和高端工作站

虽然 DDR6 将首先在服务器和人工智能相关领域进行商业部署,但随着生态系统的成熟和成本的下降,预计它将逐步渗透到消费类个人电脑和高端工作站市场。对于高端游戏笔记本电脑和旗舰台式电脑而言,DDR6 的高频率和高带宽可以改善游戏加载时间和整体流畅度。这在运行大型 AAA 游戏时尤为明显,DDR6 可以有效减少卡顿和掉帧现象。同时,CAMM2 接口带来的轻薄设计还能帮助制造商打造出更轻薄、更高性能的游戏笔记本电脑。

高端工作站也将成为首批采用 DDR6 的消费领域。移动工作站和图形工作站主要用于视频编辑、三维建模和动画渲染等专业工作负载,对内存频率、容量和稳定性的要求非常高。传统的 SO-DIMM 内存在 2DPC 配置下存在频率限制,无法满足高端工作站的性能要求。DDR6 与 CAMM2 接口的结合解决了这一问题,同时还提供了更大的容量支持。

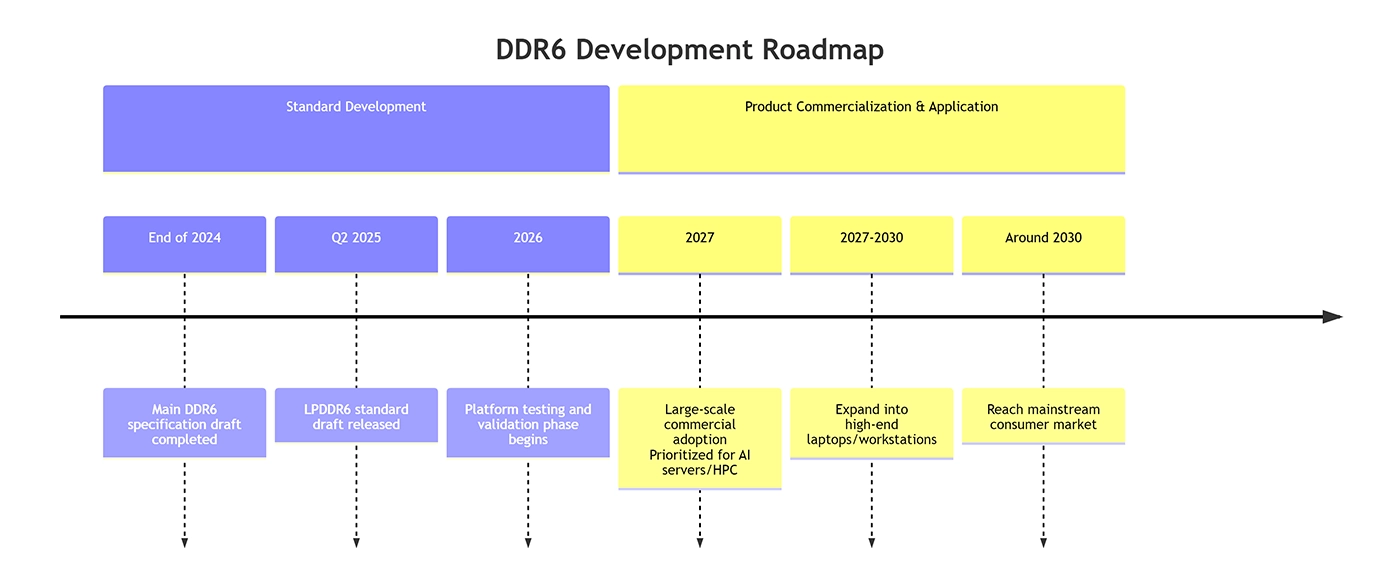

标准化进展和商业化时间表

负责主导内存技术标准的组织 JEDEC 于 2024 年底完成了主要 DDR6 规范草案。针对移动设备的 LPDDR6 标准草案也于 2025 年第二季度发布。下一阶段将是关键的平台测试和验证阶段,预计将于 2026 年进行。英特尔和 AMD 等芯片制造商将参与其中,以确保 DDR6 与未来处理器平台的兼容性。

根据行业预测,DDR6 预计将于 2027 年左右进入大规模商业部署阶段。其采用路径预计将遵循从高端到主流的模式。它将首先应用于对性能极为敏感但对成本不太敏感的领域,如人工智能服务器、高性能计算系统和数据中心。然后逐步扩展到高端笔记本电脑和工作站市场。主流台式电脑和普通笔记本电脑用户可能要到 2030 年左右才能广泛接触到 DDR6。

DDR6 不是一次简单的迭代,而是一次旨在应对根本性挑战的架构演进。其核心目标是突破当前内存带宽和能效方面的瓶颈,为人工智能、高性能计算和未来的大规模数据处理提供必要的基础架构支持。从 DDR1 到 DDR5 的发展历程展示了内存技术不断发展以满足计算需求的一贯模式。DDR6 代表了这一进程的下一个篇章。它肩负着拓展计算边界的使命,其最终形态和广泛采用将对未来十年的技术发展轨迹产生深远影响。